La inteligencia artificial generativa está transformando rápidamente diversas industrias en todo el mundo, permitiendo a las empresas ofrecer experiencias excepcionales a sus clientes, agilizar procesos y fomentar la innovación a una escala sin precedentes. Sin embargo, en medio de esta revolución tecnológica, han surgido preguntas críticas sobre el uso y la implementación responsable de estas poderosas herramientas.

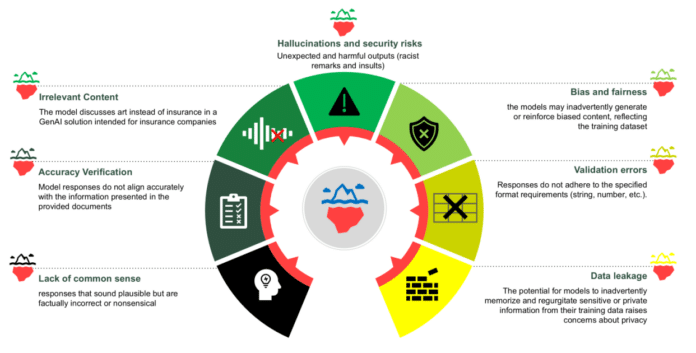

A pesar de que la inteligencia artificial responsable ha sido un enfoque central en la industria durante la última década, la creciente complejidad de los modelos generativos trae consigo desafíos únicos. Riesgos como las «alucinaciones», la falta de control, violaciones de la propiedad intelectual y comportamientos dañinos no intencionados son preocupaciones que deben abordarse de manera proactiva. Para aprovechar al máximo el potencial de la IA generativa mientras se reducen estos riesgos, es esencial adoptar técnicas de mitigación y controles integrales en el proceso de desarrollo.

El “red teaming” es una metodología que se utiliza para simular condiciones adversariales de la vida real y evaluar sistemas. En el contexto de la IA generativa, se trata de someter a los modelos a pruebas rigurosas para identificar debilidades y evaluar la resiliencia. Esta práctica ayuda a desarrollar sistemas de inteligencia artificial que sean funcionales, seguros y dignos de confianza. Al integrar el red teaming en el ciclo de vida del desarrollo de la IA, las organizaciones pueden anticipar amenazas y promover la confianza en sus soluciones de inteligencia artificial.

Los sistemas de IA generativa, aunque son transformadores, presentan desafíos de seguridad que requieren enfoques especializados. Las vulnerabilidades inherentes a estos modelos pueden incluir la capacidad de generar respuestas alucinadas, contenido inapropiado o nocivo y la divulgación no autorizada de datos sensibles. Estos potenciales riesgos podrían ser explotados por adversarios mediante diversas técnicas, como la inyección de comandos.

Data Reply ha colaborado con AWS para ofrecer apoyo y mejores prácticas en la integración de la IA responsable y el red teaming en los flujos de trabajo de las organizaciones. Esto incluye la mitigación de riesgos inesperados, el cumplimiento de regulaciones emergentes y la reducción de la probabilidad de filtración de datos o uso malicioso de los modelos.

Para abordar estos desafíos, Data Reply ha desarrollado el Red Teaming Playground, un entorno de pruebas que combina varias herramientas de código abierto con los servicios de AWS, permitiendo a los creadores de IA explorar escenarios y evaluar las reacciones de los modelos en condiciones adversariales. Este enfoque es crucial para identificar riesgos y mejorar la robustez y la seguridad de los sistemas de IA generativa.

Un ejemplo ejemplar podría ser un asistente de triaje de salud mental. Este tipo de aplicación requiere un manejo muy cuidadoso de temas sensibles. Definiendo un caso de uso claro y estableciendo expectativas de calidad, el modelo puede ser guiado sobre cuándo responder, desviar o proporcionar una respuesta segura.

La mejora continua en la implementación de políticas de IA responsable es fundamental. La colaboración entre Data Reply y AWS busca industrializar esfuerzos que van desde chequeos de equidad hasta pruebas de seguridad, ayudando a las organizaciones a mantenerse a la vanguardia de las amenazas emergentes y los estándares en evolución.

vía: AWS machine learning blog