Los modelos de lenguaje grandes (LLMs) han mostrado capacidades prometedoras en las tareas de traducción automática (MT). Según el caso de uso, estos modelos son capaces de competir con modelos de traducción neuronal como Amazon Translate. Una de las características más destacables de los LLMs es su capacidad innata para aprender del contexto del texto de entrada, lo que les permite captar matices culturales y producir traducciones que suenan más naturales.

La traducción de una pregunta como «¿Te desempeñaste bien?» puede diferir significativamente de un idioma a otro dependiendo del contexto. Por ejemplo, en un contexto deportivo, la pregunta formulada como «¿Te desempeñaste bien en el torneo de fútbol?» requeriría una traducción en francés que refleje esa especificidad cultural. Es fundamental que los modelos de inteligencia artificial no solo capten el contexto, sino también las particularidades culturales para lograr una traducción más fluida y precisa.

Varios clientes en todo el mundo están buscando aprovechar esta capacidad de los LLMs para mejorar la calidad de su contenido traducido. La localización se basa en un proceso de Traducción Automática con Edición Posteriore (MTPE), que combina la automatización con el trabajo humano. Desarrollar soluciones que ayuden a mejorar la calidad del contenido traducido presenta múltiples beneficios, como ahorro de costos en las actividades de MTPE, tiempos de entrega más rápidos para los proyectos de localización y una mejor experiencia para los consumidores de contenido.

Sin embargo, los LLMs también han presentado algunas brechas en las tareas de traducción automática, incluyendo calidad inconsistente en ciertos pares de idiomas, la ausencia de un patrón estándar para integrar el conocimiento de traducciones anteriores (lo que se conoce como memoria de traducción o TM) y el riesgo inherente de «alucinación» en sus salidas.

El cambio hacia cargas de trabajo de MT impulsadas por LLM debe considerar cada caso por separado, pero la industria está reconociendo un potencial suficiente para considerar a estas herramientas como una opción valiosa.

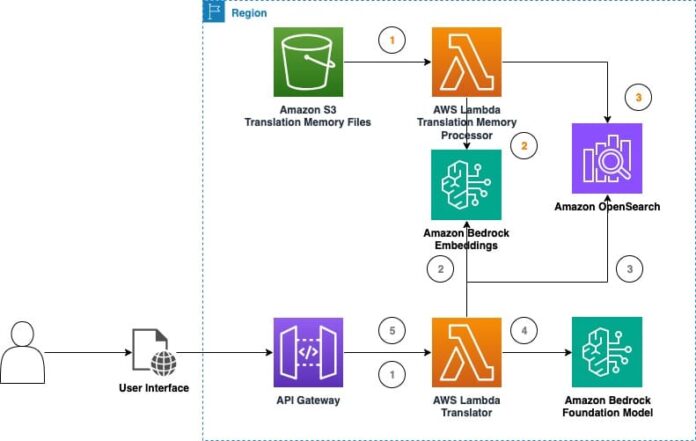

Con el fin de experimentar con la traducción automática en tiempo real utilizando modelos de base disponibles en Amazon Bedrock, se ha presentado una solución que permite recolectar más datos sobre el valor de los LLMs en casos de uso de traducción de contenido. Esta solución utiliza técnicas de memoria de traducción y archivos TMX, importantes en el ámbito de las herramientas de traducción asistida por computadora y sistemas de gestión de traducción. Una memoria de traducción es una base de datos que almacena segmentos de texto traducidos previamente, lo que ayuda a los traductores a aumentar su eficiencia y consistencia, especialmente en proyectos con contenido repetitivo.

La combinación de TMs con LLMs puede mejorar notablemente la calidad y eficiencia de la traducción automática. Al aprovechar las traducciones de alta calidad almacenadas en las TMs, los LLMs pueden mejorar la exactitud y consistencia de las traducciones producidas. Las TMs que contienen traducciones específicas de un dominio también permiten a los LLMs adaptarse mejor a la terminología y el estilo del contenido en traducción.

El uso de memoria de traducción puede reducir el esfuerzo de edición posterior, lo que contribuye a una mayor productividad y ahorros en costos. Esta integración puede realizarse sin complicaciones operativas significativas utilizando estrategias de aprendizaje del contexto de los LLMs y técnicas de ingeniería de prompt, lo que facilita a las empresas usar modelos preexistentes.

El «parque de pruebas de traducción LLM» es una aplicación que permite experimentar con las capacidades de traducción de los LLMs y proporciona una serie de herramientas útiles, incluyendo la posible creación y comparación de diversas configuraciones de inferencia y la evaluación del impacto de la ingeniería de prompts y generación aumentada por recuperación en la traducción.

En una prueba simple, se comprobó cómo los LLMs son capaces de adaptarse naturalmente al contexto de las frases, evidenciando su capacidad para mejorar la calidad de la traducción y la experiencia del usuario en base a contextos definidos y relevantes. A través de experimentos con memoria de traducción, se demostró un aumento notable en la calidad de las traducciones, lo que sugiere que esta combinación de técnicas puede resultar crucial para futuros proyectos de localización y traducción de contenido.

La continua exploración y el desarrollo de LLMs para traducción automática prometen no solo mejorar la calidad de las traducciones, sino también hacer que el proceso de localización sea más eficiente y accesible para empresas de todos los tamaños.

vía: AWS machine learning blog