En la actualidad, las redes sociales han revolucionado la forma en que las marcas interactúan con sus consumidores, creando una necesidad de contenido dinámico y atractivo que resuene con su audiencia objetivo. En este espacio, hay una creciente competencia por la atención del consumidor; los creadores de contenido y los influencers enfrentan desafíos constantes para producir contenido nuevo, atractivo y consistente con la marca. Estos desafíos provienen de tres factores clave: la necesidad de una producción rápida de contenido, el deseo de contenido personalizado que sea cautivador y visualmente atractivo, y que refleje los intereses únicos del consumidor, y la necesidad de contenido que sea consistente con la identidad, el mensaje, la estética y el tono de la marca.

Tradicionalmente, el proceso de creación de contenido ha sido una tarea que consume mucho tiempo e involucra múltiples pasos como la ideación, investigación, escritura, edición, diseño y revisión. Este ciclo lento de creación no se adapta al ritmo rápido de las redes sociales.

La IA generativa ofrece nuevas posibilidades para abordar estos desafíos y puede ser utilizada por equipos de contenido e influencers para mejorar su creatividad y engagement mientras mantienen la consistencia de la marca. Más específicamente, las capacidades multimodales de los grandes modelos de lenguaje (LLMs) nos permiten crear contenido rico y atractivo que abarca texto, imágenes, audio y video, formatos que son omnipresentes en la publicidad, el marketing y el contenido de redes sociales. Con los recientes avances en los LLMs vision, los creadores pueden usar entrada visual, como imágenes de referencia, para iniciar el proceso de creación de contenido. La búsqueda de similitud de imagen y búsqueda semántica de texto mejoran aún más el proceso al recuperar rápidamente contenido y contexto relevantes.

En este artículo, presentamos un proceso paso a paso para crear una aplicación generadora de contenido para redes sociales utilizando modelos de visión, lenguaje y embeddings (Claude 3 de Anthropic, el generador de imágenes Amazon Titan y las embeddings multimodales de Amazon Titan) a través de la API de Amazon Bedrock y Amazon OpenSearch Serverless. Amazon Bedrock es un servicio totalmente gestionado que proporciona acceso a modelos básicos de alto rendimiento de compañías líderes en IA a través de una única API. OpenSearch Serverless es un servicio totalmente gestionado que facilita el almacenamiento de vectores y otros tipos de datos en un índice y permite realizar consultas con latencias de subsegundo al buscar billones de vectores y medir la similitud semántica.

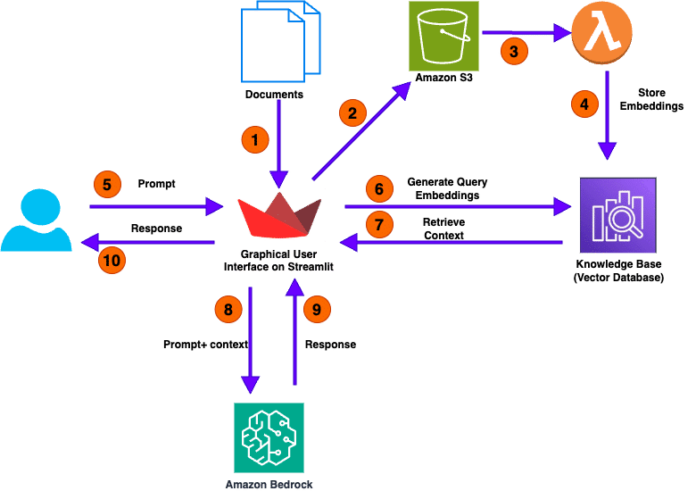

Así es como funciona el proceso propuesto para la creación de contenido:

1. Primero, el usuario, ya sea del equipo de contenido o de marketing, sube una imagen del producto con un fondo simple (como un bolso). Luego, proporciona descripciones en lenguaje natural de la escena y las mejoras que desea agregar a la imagen como un prompt (por ejemplo, «decoraciones de vacaciones de Navidad»).

2. A continuación, el generador de imágenes Amazon Titan crea la imagen mejorada según el escenario proporcionado.

3. Luego, se genera un texto rico y atractivo que describe la imagen mientras se alinea con las directrices y el tono de la marca utilizando Claude 3.

4. Después de crear el borrador (texto e imagen), nuestra solución realiza búsquedas de similitud multimodal contra publicaciones históricas para encontrar publicaciones similares y obtener inspiración y recomendaciones para mejorar la publicación del borrador.

5. Finalmente, basándose en las recomendaciones generadas, el texto de la publicación se refina aún más y se proporciona al usuario en la página web.

En esta solución, comenzamos con la preparación de datos, donde los conjuntos de datos en bruto pueden almacenarse en un bucket de Amazon S3. Proporcionamos un cuaderno de Jupyter para preprocesar los datos en bruto y usar el modelo de embeddings multimodales de Amazon Titan para convertir la imagen y el texto en vectores de embeddings. Estos vectores se guardan en OpenSearch Serverless como colecciones.

El siguiente paso es la generación de contenido. La página web GUI está alojada utilizando una aplicación Streamlit, donde el usuario puede proporcionar una imagen inicial del producto y una breve descripción de cómo espera que se vea la imagen enriquecida. Desde la aplicación, el usuario también puede seleccionar la marca (que se vinculará a una plantilla específica de la marca más adelante), elegir el estilo de la imagen (como fotográfico o cinematográfico) y seleccionar el tono para el texto de la publicación (como formal o casual).

Después de proporcionar todas las configuraciones, se lanza el proceso de creación de contenido.

En la etapa 1, la solución recupera la plantilla y las guías específicas de la marca de un archivo CSV. En un entorno de producción, podría mantener la tabla de plantillas de marca en Amazon DynamoDB para escalabilidad, fiabilidad y mantenimiento. La entrada del usuario se utiliza para generar la imagen enriquecida con el generador de imágenes Amazon Titan. Junto con toda la otra información, se alimenta al modelo de Claude 3, que tiene capacidad de visión, para generar el texto inicial de la publicación que se alinea de cerca con las guías de la marca y la imagen enriquecida. Al final de esta etapa, se crea la imagen enriquecida y el texto inicial de la publicación y se envían de vuelta a la GUI para mostrarse a los usuarios.

En la etapa 2, combinamos el texto e imagen de la publicación y utilizamos el modelo de embeddings multimodales de Amazon Titan para generar el vector de embeddings. Los modelos de embeddings multimodales integran información de diferentes tipos de datos, como texto e imágenes, en una representación unificada. Esto permite buscar imágenes utilizando descripciones de texto, identificar imágenes similares basándose en el contenido visual, o combinar entradas de texto e imagen para refinar los resultados de búsqueda. En esta solución, el vector de embeddings multimodal se utiliza para buscar y recuperar las tres publicaciones históricas similares de la tienda vectorial de OpenSearch. Los resultados recuperados se alimentan al modelo Claude 3 de Anthropic para generar un pie de foto, proporcionar ideas de por qué estas publicaciones históricas son atractivas y ofrecer recomendaciones sobre cómo el usuario puede mejorar su publicación.

En la etapa 3, basándose en las recomendaciones de la etapa 2, la solución refina automáticamente el texto de la publicación y proporciona una versión final al usuario. El usuario tiene la flexibilidad de seleccionar la versión que le guste y realizar cambios antes de publicarla. Para el proceso completo de generación de contenido, los pasos se orquestan con la aplicación Streamlit.

Cuando se termina de experimentar con esta solución, es importante limpiar los recursos de AWS utilizados para evitar costos innecesarios, como eliminar el bucket de Amazon S3 y los datos creados, eliminar la colección de Amazon OpenSearch Serverless, y eliminar la aplicación en ejecución de Amazon SageMaker.

En conclusión, este generador de contenido multimodal para redes sociales utiliza modelos de Amazon Bedrock para crear contenido rápidamente, permitiendo a las marcas e influencers producir contenido atractivo y consistente con la marca.

vía: AWS machine learning blog