La inteligencia artificial generativa avanza a pasos agigantados, con el lanzamiento continuo de nuevas herramientas y modelos. Según Gartner, la inteligencia artificial agencial es una de las principales tendencias tecnológicas para 2025. Las organizaciones se encuentran en la fase de prototipado para explorar cómo utilizar estos agentes en sus entornos empresariales. Uno de los retos más significativos radica en la necesidad de herramientas que puedan comunicarse entre sí, elemento que aborda el Protocolo de Contexto del Modelo (MCP), una iniciativa de Anthropic.

El MCP es un protocolo de código abierto que busca establecer un estándar de comunicación entre diferentes herramientas, lo que facilita a las aplicaciones basadas en modelos de lenguaje conectar APIs empresariales y herramientas externas de una manera estandarizada. Sin embargo, su implementación en grandes organizaciones, como las del sector financiero, se complica debido a la complejidad en la gobernanza de datos y modelos operativos.

Los equipos suelen construir herramientas de manera independiente, generando duplicación de esfuerzos y desperdicio de recursos. Este enfoque silo provoca una reducción en la innovación y crea inconsistencias en la integración de los sistemas, lo que a su vez dificulta la escalabilidad de las iniciativas de inteligencia artificial. A pesar de estas dificultades, la implementación de soluciones generativas puede beneficiarse enormemente en áreas como el procesamiento de post-operaciones, la automatización de atención al cliente y el cumplimiento regulatorio.

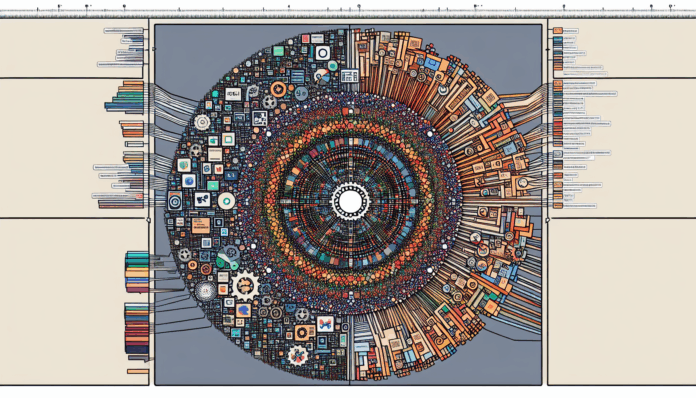

Un enfoque innovador propuesto es el uso de un servidor centralizado de MCP con Amazon Bedrock. Este sistema ofrece acceso compartido a herramientas y recursos, permitiendo a los equipos centrarse en desarrollar capacidades de inteligencia artificial en lugar de mantener herramientas. Al estandarizar el acceso mediante el MCP, se puede acelerar el desarrollo de agentes de inteligencia artificial y mejorar la gobernanza y seguridad al gestionar el acceso de manera centralizada, reduciendo el riesgo de exfiltración de datos.

En el caso de una organización financiera, el uso de servidores MCP puede gestionarse a través de diferentes líneas de negocio, cada una con funciones específicas. Por ejemplo, la línea de negocio de comercio se encarga de la ejecución de operaciones, mientras que otra de gestión de riesgos se ocupa de los controles necesarios. Esto permite que cada división desarrolle servidores MCP que se integran en un registro central, facilitando la colaboración y el uso eficiente de soluciones impulsadas por inteligencia artificial.

La arquitectura que sustenta esta solución incluye una API de descubrimiento de servidores MCP, aplicaciones agenciales alojadas en AWS Fargate y un hub central de servidores MCP, entre otros componentes. Juntos, estos elementos garantizan que la infraestructura sea escalable y esté diseñada con un alto enfoque en la seguridad.

Los beneficios de esta solución son significativos, ya que ofrece escalabilidad y resiliencia sin que las organizaciones necesiten gestionar la infraestructura. La seguridad se refuerza mediante controles en la red, asegurando que las aplicaciones solo se conecten a servidores MCP de confianza dentro de la organización.

La implementación de este modelo no solo está dirigida a la industria financiera, sino que puede aplicarse a diversas cargas de trabajo empresariales. Se propone una serie de pasos para la implementación y uso de una aplicación agencial en escenarios de ejecución de operaciones post-trade, mediante la invocación de herramientas a través del servidor MCP.

En resumen, esta solución proporciona un enfoque pragmático y centralizado para la implementación de servidores MCP en AWS, permitiendo a las organizaciones centrarse en el desarrollo de aplicaciones innovadoras, mientras superan las ineficiencias operativas. La facilidad de acceso que ofrece un entorno centralizado puede acelerar el camino hacia flujos de trabajo más inteligentes y mejores resultados para los clientes.

vía: AWS machine learning blog