Las operaciones de aprendizaje automático, conocidas como MLOps, son un conjunto de prácticas diseñadas para automatizar y simplificar los flujos de trabajo y despliegues del aprendizaje automático (ML). Conforme las cargas de trabajo de ML se vuelven cada vez más complejas y consumen más energía y recursos, un número creciente de empresas busca maneras de gestionar tanto los costos como la huella de carbono asociada con estas cargas. AWS ha publicado una guía para optimizar los MLOps con un enfoque en la sostenibilidad, ayudando a los clientes a maximizar la utilización y minimizar el desperdicio en sus cargas de ML.

El proceso completo de construcción, despliegue y uso de modelos de ML incluye principalmente tres flujos de trabajo: preparación de datos, entrenamiento y ajuste del modelo, y despliegue y gestión del modelo. Comenzando con la preparación de datos, que es esencial para el entrenamiento del modelo, se pueden optimizar las cargas de trabajo empleando las mejores prácticas de sostenibilidad en AWS. Factores como la selección de una región de AWS con baja intensidad de carbono y el uso de una arquitectura sin servidor pueden reducir el consumo de energía.

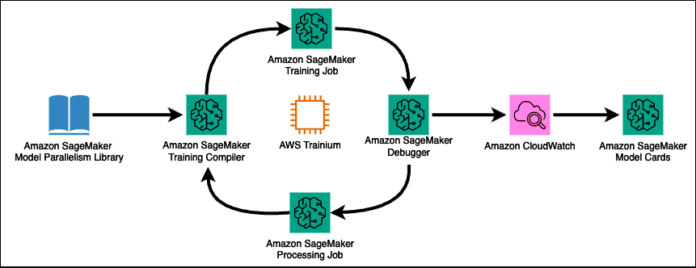

En la fase de entrenamiento y ajuste del modelo, que es específica para cargas de trabajo de AI/ML, la optimización no solo mejora la funcionalidad de los modelos sino también la eficiencia operativa. AWS SageMaker proporciona herramientas como la biblioteca de modelos paralelos y el SageMaker Training Compiler para entrenar eficientemente modelos de gran tamaño, y el ajuste automático de modelos (AMT) para optimizar los hiperparámetros, reduciendo así el uso de recursos y la huella de carbono.

La última fase, despliegue y gestión de modelos, también ofrece oportunidades de optimización. Utilizar características como el Amazon SageMaker Model Registry y los endpoints multi-modelo puede mejorar la eficiencia y sostenibilidad, evitando la redundancia en los recursos y permitiendo la reutilización de modelos. Además, el despliegue de modelos puede ser automatizado y ajustado durante los picos de carga usando escalado automático, y los endpoints de inferencia asincrónicos pueden ayudar a minimizar los recursos inactivos.

La integración de la sostenibilidad en el diseño, desarrollo y despliegue de modelos de ML se ha convertido en una consideración crucial a largo plazo. AWS está invirtiendo en la sostenibilidad de la nube y proporcionando recursos para ayudar a los clientes a transformar sus cargas de trabajo para que sean más eficientes en términos de energía. Así, se puede reducir el impacto ambiental utilizando herramientas y servicios específicos de AWS, como el SageMaker Model Monitor y el AWS Inferentia.

Incorporar prácticas de sostenibilidad en las operaciones de MLOps no solo es beneficioso para el medio ambiente sino también para la eficiencia operativa de las empresas. La revisión regular de estas prácticas utilizando herramientas como el AWS Well-Architected Machine Learning Lens permite identificar oportunidades de optimización y proporciona una vía para alcanzar los objetivos de sostenibilidad organizacionales.

vía: AWS machine learning blog