En un movimiento significativo hacia la mejora de los servicios, Crypto.com ha implementado un asistente basado en inteligencia artificial generativa en su plataforma, utilizando tecnologías de AWS. Este avance tiene como objetivo optimizar la calidad del servicio para sus 140 millones de usuarios, distribuidos en 90 países.

Los asistentes de inteligencia artificial modernos enfrentan crecientes desafíos. Más allá de responder preguntas simples, deben realizar acciones significativas y cumplir con las políticas de la empresa, lo que implica una mayor complejidad en su funcionamiento. Para abordar estos desafíos, la arquitectura modular se presenta como una solución efectiva, permitiendo dividir el sistema de inteligencia artificial en componentes especializados que operan de manera independiente mientras colaboran en un todo cohesivo.

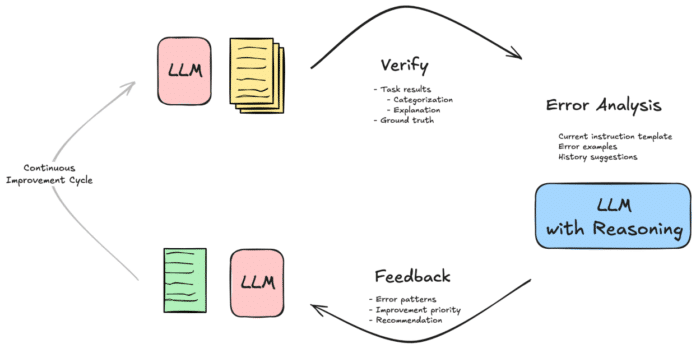

Un aspecto crucial en la mejora de estos sistemas es la ingeniería de prompts, que se refiere al arte de redactar instrucciones que guían las respuestas de los modelos de lenguaje. Esto es especialmente importante en entornos empresariales donde la precisión y la fiabilidad son esenciales. La incorporación de ciclos de retroalimentación se convierte en un elemento fundamental que permite a estos modelos aprender de sus errores y ajustar sus respuestas en consecuencia.

Un enfoque innovador es la crítica, que consiste en emparejar modelos de lenguaje grande (LLMs) con mecanismos externos que ofrecen retroalimentación. Este método permite que el modelo corrija sus salidas y se adapte a situaciones desafiantes, mejorando su efectividad y fiabilidad. Por ejemplo, un asistente de inteligencia artificial que maneja consultas sobre límites de crédito puede inicialmente omitir pasos importantes de verificación, pero con un sistema de crítica, puede aprender a incluir estos procedimientos en sus respuestas.

La efectividad de estos mecanismos de retroalimentación no solo se limita a corregir errores, sino que también permite a los LLMs desarrollar una comprensión más matizada de las instrucciones. A lo largo de varias iteraciones de retroalimentación, los modelos pueden ajustar sus estrategias de procesamiento, anticipando posibles malentendidos y ajustando su enfoque.

A través de un proceso de refinamiento iterativo, el equipo de Crypto.com ha transformado un conjunto básico de instrucciones en un sistema robusto que mejora constantemente a través de la retroalimentación. Durante sus pruebas, observaron una mejora notable, pasando de una tasa de precisión del 60% a un impresionante 94%. Esto valida la eficacia de su estrategia de optimización iterativa.

El enfoque que han adoptado demuestra cómo los asistentes de inteligencia artificial pueden evolucionar de sistemas estáticos a herramientas dinámicas y auto-mejorables. De cara al futuro, la refinación continua de los mecanismos de retroalimentación y las técnicas de ingeniería de prompts será esencial para desarrollar sistemas de asistencia de IA cada vez más sofisticados y confiables.

vía: AWS machine learning blog