Los clientes están cada vez más interesados en aprovechar el potencial de los grandes modelos de lenguaje (LLMs) para resolver problemas reales. Sin embargo, la conexión entre estos LLMs y sus aplicaciones prácticas ha resultado ser un desafío. En este contexto, los agentes de inteligencia artificial emergen como una tecnología innovadora que puede cerrar esta brecha.

Los modelos de base (FMs) disponibles a través de Amazon Bedrock sirven como motor cognitivo para estos agentes de IA, proporcionando las capacidades de razonamiento y comprensión del lenguaje natural necesarias para interpretar solicitudes de los usuarios y generar respuestas adecuadas. Estos modelos se pueden integrar con diversas capas de orquestación y marcos de agentes para crear aplicaciones de IA que comprenden el contexto, toman decisiones y ejecutan acciones. Se pueden construir aplicaciones utilizando Amazon Bedrock Agents, así como otros marcos como LangGraph y el recientemente lanzado Strands Agent SDK.

Para los equipos que buscan una solución gestionada que optimice los flujos de trabajo en GitHub, Amazon Q Developer en GitHub ofrece una integración nativa con los repositorios de GitHub, brindando capacidades integradas para la generación, revisión y transformación de código sin necesidad de desarrollar agentes personalizados. Mientras que Amazon Q Developer proporciona funcionalidad lista para usar para flujos de trabajo comunes, las organizaciones con requisitos específicos pueden beneficiarse de crear soluciones personalizadas utilizando Amazon Bedrock y marcos de agentes. Esta flexibilidad permite a los equipos elegir entre una solución lista para usar o un enfoque personalizado según sus necesidades particulares y los niveles deseados de control sobre la implementación.

A pesar de los avances significativos en la tecnología de agentes de IA, el estado actual de su desarrollo y despliegue enfrenta desafíos críticos que limitan su efectividad y la adopción más amplia. Estos obstáculos abarcan dominios técnicos, operativos y conceptuales. Uno de los desafíos más significativos es la integración de herramientas. Aunque existen marcos como Amazon Bedrock Agents, LangGraph y el Strands Agent SDK que permiten a los agentes interactuar con herramientas y servicios externos, los enfoques actuales a menudo carecen de estandarización y flexibilidad. Esto obliga a los desarrolladores a crear integraciones personalizadas y a manejar numerosos casos límite en la invocación de herramientas y el procesamiento de respuestas.

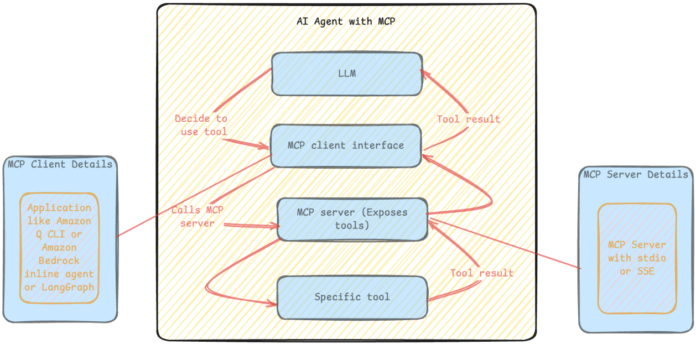

En respuesta a las limitaciones actuales, el Protocolo de Contexto del Modelo (MCP) proporciona un marco estandarizado que redefine fundamentalmente la relación entre los FMs, la gestión del contexto y la integración de herramientas. Este protocolo aborda muchos de los problemas centrales que han obstaculizado la adopción más amplia y la efectividad de los agentes de IA, especialmente en entornos empresariales y casos de uso complejos.

La integración del MCP permite simplificar drásticamente la integración de herramientas a través de un registro de herramientas y patrones de invocación estandarizados. Esto no solo reduce el esfuerzo de desarrollo necesario para integrar nuevas herramientas, sino que también habilita patrones de uso más sofisticados, como encadenamientos de herramientas y llamadas paralelas.

Esta combinación de tecnologías, que incluye los FMs de alta calidad de Amazon Bedrock, las capacidades de gestión del contexto del MCP y el marco de orquestación de LangGraph, puede generar agentes capaces de realizar tareas cada vez más complejas con mayor fiabilidad y efectividad. Imagina que tu equipo de desarrollo se despierta y encuentra que los problemas de GitHub del día anterior ya han sido analizados, corregidos y listos como solicitudes de extracción, todo manejado de manera autónoma durante la noche.

La reciente evolución de los LLMs, especialmente aquellos con capacidades de generación de código, representa un enfoque impactante para los flujos de trabajo de desarrollo. Mediante el uso de agentes, los equipos pueden automatizar cambios sencillos, como actualizaciones de dependencias o correcciones de errores.

Amazon Bedrock es un servicio totalmente gestionado que pone a disposición modelos de alto rendimiento de empresas líderes en IA a través de una API unificada. También ofrece una amplia gama de capacidades para construir aplicaciones de IA generativa con seguridad y responsabilidad. LangGraph orquesta flujos de trabajo de agentes mediante una arquitectura basada en grafos que maneja procesos complejos y mantiene el contexto a lo largo de las interacciones del agente.

El MCP empodera a los desarrolladores para establecer conexiones seguras y bidireccionales entre sus fuentes de datos y herramientas impulsadas por IA, facilitando la automatización de tareas y el análisis de código sin lidiar con complejas llamadas a APIs. La integración fluida con GitHub permite a los desarrolladores aprovechar sus repositorios para mejorar los flujos de trabajo de manera eficiente.

La implementación de este sistema orientado a la automatización no solo busca mejorar la productividad, sino también transformarla al abordar las limitaciones actuales de los agentes de IA. Con un enfoque en la colaboración entre IA y desarrolladores humanos, el futuro de la automatización en el desarrollo promete una serie de oportunidades si se manejan adecuadamente los desafíos asociados.

vía: AWS machine learning blog