Los modelos de lenguaje a gran escala (LLMs, por sus siglas en inglés) han avanzado drásticamente, evolucionando de ser capaces de leer únicamente texto a ahora interpretar y entender gráficos, diagramas, tablas e imágenes. En este contexto, Amazon Bedrock se ha posicionado como una plataforma esencial, ofreciendo un servicio completamente gestionado que integra modelos de fundación de alto rendimiento de diversas compañías líderes en inteligencia artificial. Este servicio permite no solo extraer texto, sino también comprender información contenida en imágenes, lo cual abre un abanico de posibilidades para aplicaciones de inteligencia artificial generativa en diversos campos.

Amazon Bedrock, gracias a su API única, proporciona un acceso integral a modelos de compañías como AI21 Labs, Anthropic, Cohere, Meta, entre otras, facilitando así la construcción de aplicaciones generativas con un enfoque en seguridad, privacidad y responsabilidad. Un aspecto destacable es su capacidad para realizar tareas de clasificación y detección de objetos mediante técnicas de prompting de cero disparos, que permiten asignar tareas a los modelos sin ejemplos específicos de entrenamiento.

Además de estas capacidades, Amazon Bedrock ofrece la posibilidad de leer y consultar gráficos complejos. Un ejemplo claro es su aplicación en la interpolación y extrapolación de datos de crecimiento poblacional de gráficos, lo cual demuestra su habilidad no solo para interpretar datos estáticos, sino también para anticipar tendencias futuras basándose en conjuntos de datos limitados.

El potencial de Amazon Bedrock no se limita a la interpretación de imágenes y gráficos; también se extiende a la creación de listados inmobiliarios a partir de planos de plantas e imágenes de propiedades, y a la generación de recetas culinarias basándose en imágenes de platos. Este último uso destaca los desafíos de precisar los ingredientes y las técnicas de cocina basándose solo en el reconocimiento visual, una tarea que los modelos avanzados están empezando a abordar.

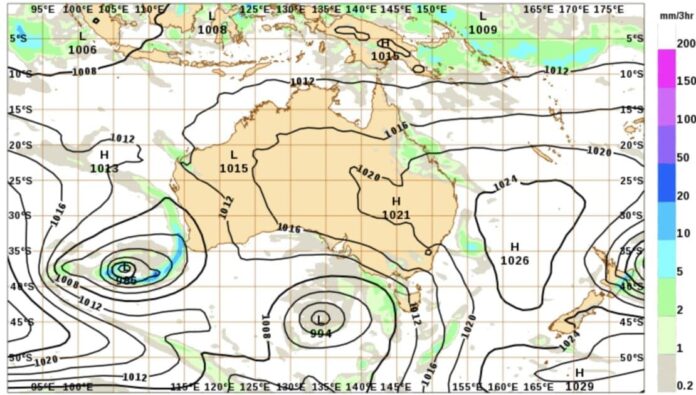

La plataforma también es capaz de analizar mapas de precipitaciones, para responder a preguntas específicas sobre condiciones climáticas en ubicaciones concretas, como si llueve en Sydney al observar un mapa de precipitaciones. Esto pone de manifiesto la capacidad de los modelos para trabajar con información aproximada, semejante a procesos cognitivos humanos.

Por otro lado, los avances en el reconocimiento de diagramas arquitectónicos también subrayan cómo estos modelos pueden servir de asesores expertos, capaces de responder a preguntas técnicas y proporcionar explicaciones detalladas sobre procesos complejos además de ofrecer sugerencias relevantes.

En conclusión, los modelos de fundación disponibles en Amazon Bedrock, como Claude 3 Sonnet de Anthropic y Llama 3.2 90B Vision de Meta, demuestran un impresionante rango de capacidades en el procesamiento de imágenes. Estas herramientas innovadoras ofrecen soluciones nuevas a problemas desafiantes, desde la búsqueda en archivos de documentos escaneados hasta la conversión de información visual en datos estructurados. Los usuarios interesados en aprovechar estas capacidades pueden comenzar a explorar la funcionalidad en el entorno de pruebas chat de Amazon Bedrock.

vía: AWS machine learning blog