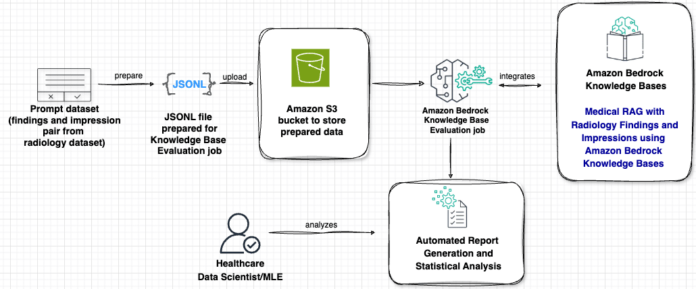

En los últimos artículos de nuestro blog, hemos analizado diferentes técnicas como el ajuste fino de modelos de lenguaje grande, la ingeniería de prompts y la Generación Aumentada por Recuperación (RAG) usando Amazon Bedrock para generar impresiones a partir de la sección de hallazgos en informes de radiología mediante inteligencia artificial generativa. En la primera parte, nos enfocamos en el ajuste de modelos, mientras que en la segunda parte se introdujo la RAG, que combina modelos de lenguaje grande con bases de conocimiento externas para reducir alucinaciones y mejorar la precisión en aplicaciones médicas. Gracias a la recuperación en tiempo real de información médica relevante, los sistemas RAG pueden proporcionar respuestas más fiables y adecuadas contextual y clínicamente, lo que los hace particularmente valiosos para aplicaciones en el sector salud, donde la precisión es crucial. En ambas publicaciones anteriores, utilizamos métricas tradicionales como las puntuaciones ROUGE para evaluar el rendimiento. Sin embargo, esta métrica es adecuada para evaluar tareas de resumen generales, pero no puede evaluar eficazmente si un sistema RAG integra con éxito conocimiento médico recuperado o mantiene la precisión clínica.

En la tercera parte, presentamos un enfoque para evaluar aplicaciones de RAG en el ámbito de la salud utilizando el modelo LLM como juez junto con Amazon Bedrock. Este innovador marco de evaluación aborda los desafíos únicos de los sistemas RAG médicos, donde tanto la precisión del conocimiento médico recuperado como la calidad del contenido médico generado deben alinearse con estándares rigurosos, tales como la claridad y la precisión clínica. Al utilizar los modelos más recientes de Amazon y la nueva función de evaluación RAG, ahora podemos evaluar de manera integral cuán bien estos sistemas recuperan y utilizan información médica para generar respuestas precisas y apropiadas en contexto.

Este avance en la metodología de evaluación es particularmente crucial a medida que las aplicaciones RAG en el sector salud se vuelven más comunes en entornos clínicos. El enfoque LLM como juez proporciona un marco de evaluación más matizado que considera tanto la calidad de la recuperación de información como la precisión clínica del contenido generado, alineándose con los estrictos estándares requeridos en el ámbito médico.

En esta publicación, demostramos cómo implementar este marco de evaluación utilizando Amazon Bedrock, comparamos el rendimiento de diferentes modelos generadores, incluyendo Claude de Anthropic y Nova de Amazon, y mostramos cómo utilizar la nueva función de evaluación RAG para optimizar parámetros de la base de conocimiento y evaluar la calidad de recuperación. Este enfoque no solo establece nuevos puntos de referencia para la evaluación médica de RAG, sino que también proporciona herramientas prácticas a los profesionales para construir aplicaciones de inteligencia artificial en el sector salud que puedan ser confiables en entornos clínicos.

vía: AWS machine learning blog