La inteligencia artificial generativa ha emergido como una fuerza transformadora, capturando la atención de diversas industrias gracias a su potencial para crear, innovar y resolver problemas complejos. Sin embargo, la transición de un concepto inicial a una aplicación lista para producción presenta tanto desafíos como oportunidades. Este proceso implica la creación de soluciones escalables, confiables e impactantes, capaces de generar valor para el negocio y satisfacción para el usuario.

Uno de los desarrollos más prometedores en este ámbito es el surgimiento de las aplicaciones de Generación Aumentada por Recuperación (RAG, por sus siglas en inglés). Este proceso optimiza la salida de un modelo base para que se refiera a una base de conocimientos externa a sus fuentes de datos de entrenamiento antes de generar una respuesta.

El camino hacia la producción de una aplicación RAG, a partir de una fase de prueba o producto mínimo viable, requiere de técnicas de optimización que aseguren que las soluciones sean confiables, rentables y de alto rendimiento. Los ingenieros de machine learning deben equilibrar cuidadosamente la calidad, el costo y la latencia según las necesidades específicas de sus casos de uso y requisitos empresariales.

Un marco de evaluación efectivo es crucial para medir y optimizar los sistemas RAG a medida que avanzan de un concepto inicial hacia una producción establecida. Este marco debe incluir métricas generales para una evaluación holística de toda la tubería RAG, así como métricas específicas para los componentes de recuperación y generación. Esto permite realizar mejoras centradas en cada fase del sistema.

Para mejorar el rendimiento del recuperador, es fundamental cómo se almacena la información en el vector store. También es importante considerar cómo se divide un documento en fragmentos, optando por estrategias de partición que mantengan relaciones inherentes dentro del documento para una recuperación más efectiva.

La calidad del generador también es vital. La redacción de un query efectivo puede influir en la precisión de la generación, así como el uso de técnicas de reranking que analicen la relevancia semántica entre la consulta y los documentos recuperados.

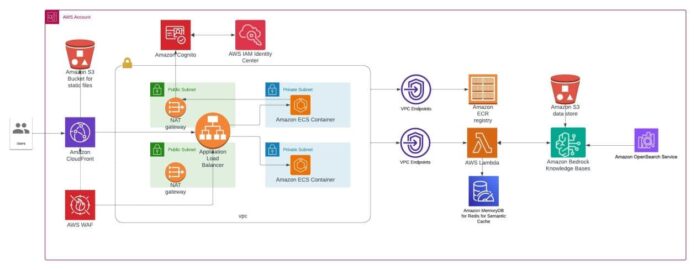

En el contexto de un proceso RAG, un equilibrio entre costo y latencia es fundamental. Se pueden implementar estrategias de almacenamiento en caché y procesamiento por lotes para mejorar el rendimiento general y reducir el uso de recursos. Asimismo, es esencial mantener la privacidad y seguridad de los datos, implementando medidas de seguridad en cada capa de la aplicación.

Los aspectos de hosting y escalado son igualmente relevantes. La selección de una solución adecuada para alojar la infraestructura, junto con herramientas de orquestación y pipelines de integración continua, facilitará la escalabilidad a medida que crezca la demanda. Es vital construir un sistema adaptado a los requisitos del flujo de trabajo de IA generativa y a las necesidades del frontend y backend.

Por último, implementar prácticas de IA responsable es crucial para asegurar un despliegue ético y seguro de estos sistemas, que incluya filtrado de contenido perjudicial y verificación de respuestas para minimizar errores. En conjunto, al abordar estos aspectos, las organizaciones pueden transformar sus pruebas de concepto basadas en RAG en soluciones robustas y listas para la producción, capaces de ofrecer un alto rendimiento, rentabilidad y respuestas de baja latencia a sus usuarios.

vía: AWS machine learning blog