La inteligencia artificial de voz está revolucionando la interacción con la tecnología, facilitando conversaciones más naturales e intuitivas. Con el desarrollo de agentes de IA avanzados, estos sistemas son ahora capaces de comprender preguntas complejas y actuar de forma autónoma en nuestro nombre.

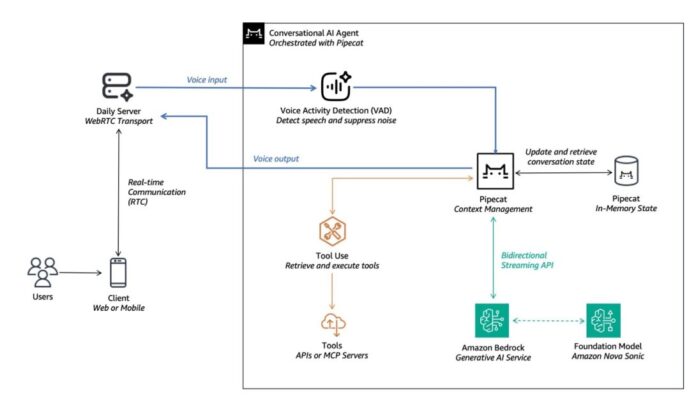

En una reciente serie de publicaciones, se presentó cómo combinar Amazon Bedrock y Pipecat, un marco de trabajo de código abierto para agentes conversacionales de voz y multimodales, para construir aplicaciones con un AI conversacional que imita la interacción humana. La primera parte de esta serie expuso casos de uso comunes de agentes de voz y un enfoque de modelos en cascada, que permite orquestar varios componentes para desarrollar estos agentes.

En la segunda entrega, se analizó el modelo de fundación de voz a voz Amazon Nova Sonic, que ofrece conversaciones en tiempo real con una calidad de voz similar a la humana, destacando su capacidad para reducir la latencia al combinar varios sistemas, como el reconocimiento automático de voz, procesamiento del lenguaje natural y conversión de texto a voz en un único modelo.

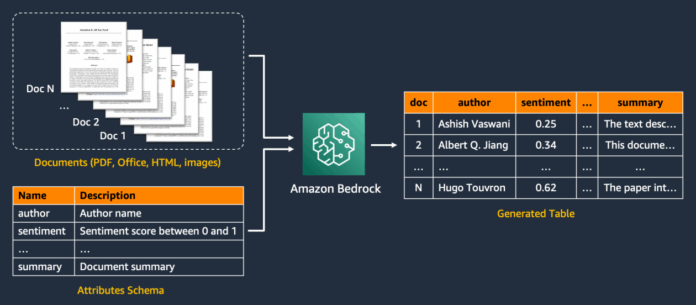

Amazon Nova Sonic no solo permite una conversación más fluida al ajustarse dinámicamente a las características acústicas y el contexto conversacional, sino que también cuenta con la capacidad de utilizar herramientas y recuperar información a través de la base de conocimiento de Amazon Bedrock. Esta unificación de capacidades simplifica el desarrollo y mejora la respuesta en entornos conversacionales.

La colaboración entre AWS y el equipo de Pipecat ha sido crucial para integrar de manera eficiente las capacidades avanzadas de este modelo, facilitando que los desarrolladores implementen sistemas de voz más inteligentes. Kwindla Hultman Kramer, CEO de Daily.co y creador de Pipecat, elogió el progreso que representa Nova Sonic, caracterizándolo como un avance significativo para la IA de voz en tiempo real, que no solo entiende sino que también puede realizar acciones significativas, como programar citas.

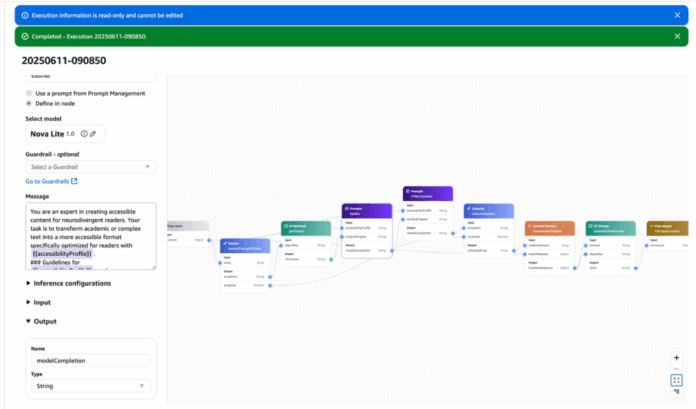

Para aquellos interesados en comenzar con Amazon Nova Sonic y Pipecat, se ofrecen ejemplos de código y pasos de implementación. Los desarrolladores pueden personalizar sus agentes de voz ajustando la lógica de conversación y la selección de modelos según sus necesidades.

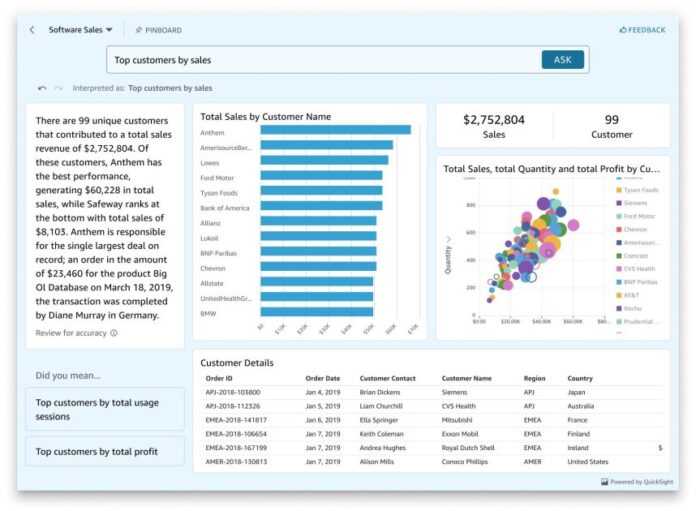

El uso de esta tecnología se ejemplificó en una demostración donde un asistente inteligente de salud podía interactuar en tiempo real, mostrando las posibilidades de la IA de voz en ámbitos prácticos.

En conclusión, la combinación de Pipecat y los modelos de fundación de Amazon Bedrock ha hecho que la creación de agentes de voz inteligentes sea más accesible. La serie de publicaciones ha abordado dos enfoques comunes para construir estos agentes, destacando cómo la simplificación de estos modelos puede llevar a mejoras significativas en la interacción y en la implementación de soluciones de IA. Con innovaciones en modelos multimodales y herramientas de avanzada, el futuro de la inteligencia artificial conversacional promete seguir expandiendo sus posibilidades en diversos sectores.

vía: AWS machine learning blog