Las aplicaciones de Retrieval Augmented Generation (RAG) han cobrado relevancia en el ámbito de la inteligencia artificial generativa, gracias a su capacidad para proporcionar información contextual relevante que mejora el rendimiento de estas tareas. Sin embargo, la implementación de aplicaciones RAG requiere una cuidadosa atención a la seguridad, especialmente cuando se manejan datos sensibles, como la información personal identificable (PII), la información de salud protegida (PHI) y los datos comerciales confidenciales. La protección de esta información es crucial, ya que fluye a través de los sistemas RAG. Ignorar estas consideraciones de seguridad puede acarrear riesgos significativos y posibles brechas de datos. Para organizaciones del sector salud, instituciones financieras y empresas que manejan información confidencial, estos riesgos pueden resultar en violaciones de cumplimiento regulatorio y en una pérdida de confianza por parte de los clientes.

Desarrollar un modelo de amenaza integral para las aplicaciones de IA generativa puede ayudar a identificar vulnerabilidades potenciales relacionadas con la fuga de datos sensibles, las inyecciones de comandos y el acceso no autorizado a datos. Para contribuir a este esfuerzo, AWS ofrece una variedad de estrategias de seguridad para IA generativa, esenciales para la creación de modelos de amenazas apropiados.

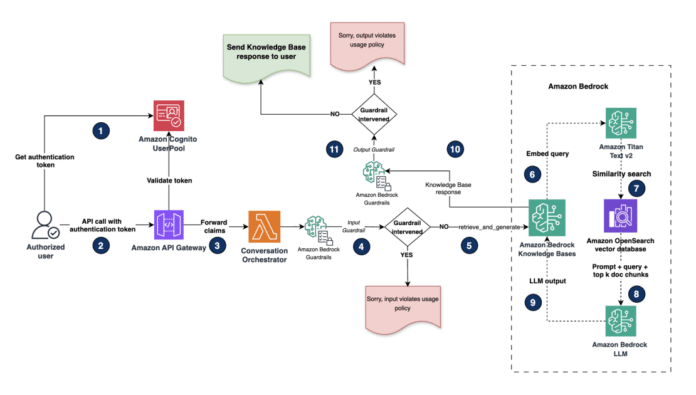

Entre las herramientas disponibles, Amazon Bedrock Knowledge Bases simplifica la gestión del flujo de trabajo RAG, permitiendo que las organizaciones proporcionen a los modelos básicos y agentes información contextual proveniente de fuentes de datos privadas, lo que resulta en respuestas más relevantes y precisas adaptadas a necesidades específicas. Con Amazon Bedrock Guardrails, es posible implementar salvaguardias en las aplicaciones de IA generativa que están personalizadas para los casos de uso y políticas de IA responsable, asegurando la redacción de información sensible como PII para proteger la privacidad.

El flujo de trabajo de RAG consta de dos pasos fundamentales: la ingestión y la recuperación aumentada. Durante la fase de ingestión, los registros de datos no estructurados son preprocesados, transformados en documentos de texto y divididos en fragmentos. Estos fragmentos se codifican mediante un modelo de incrustación y se almacenan en un vector store, como Amazon OpenSearch Service. En la etapa de recuperación aumentada, una consulta del usuario se codifica y se utiliza para realizar una búsqueda de similitud en los fragmentos almacenados, lo que permite recuperar información semánticamente similar a la consulta original. Sin embargo, si los datos sensibles no se sanitizan antes de la ingestión, existe el riesgo de que esta información pueda ser recuperada y divulgada a usuarios no autorizados.

Para salvaguardar la información sensible, se proponen dos patrones arquitectónicos: la redacción de datos a nivel de almacenamiento y el acceso basado en roles, que son soluciones robustas para proteger datos sensibles al construir aplicaciones basadas en RAG usando Amazon Bedrock Knowledge Bases.

El enfoque de redacción de datos a nivel de almacenamiento implica identificar y redactar información sensible antes de almacenar los documentos en el vector store. Por otro lado, el acceso basado en roles controla el acceso selectivo a información sensible según los roles de usuario y permisos durante la recuperación, lo cual es particularmente útil en entornos como la salud, donde es crucial diferenciar entre roles administrativos y no administrativos.

En conclusión, las aplicaciones de RAG ofrecen recursos significativos para las organizaciones que buscan mejorar la eficacia de la IA generativa, pero requieren una atención especial a la seguridad y la protección de datos sensibles. La implementación de estos enfoques no solo ayuda a mitigar riesgos, sino que también asegura la confianza de los clientes y el cumplimiento normativo.

vía: AWS machine learning blog