La integración de modelos de lenguaje masivo (LLM) con la nueva técnica de Generación Aumentada con Recuperación (RAG) está transformando radicalmente la creación de contenido y el uso de motores de búsqueda y asistentes virtuales. Esta innovadora metodología permite a los LLM acceder a bases de conocimiento externas, optimizando tanto la precisión como la relevancia de las respuestas generadas sin necesidad de volver a entrenar extensamente el modelo.

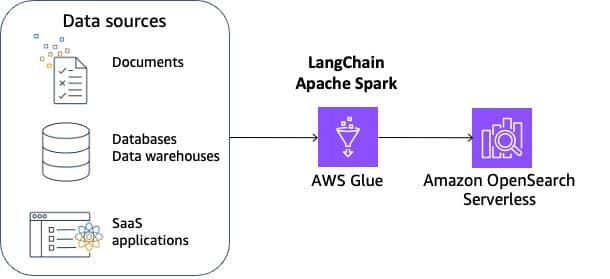

Uno de los mayores retos de la implementación de RAG es la ingeniería de datos necesaria para procesar y almacenar información externa en formatos diversos, como archivos o registros de bases de datos. Para lograr esto, se ha desarrollado una solución basada en LangChain, un marco de código abierto que se combina con herramientas de Amazon Web Services (AWS) como AWS Glue y Amazon OpenSearch Serverless.

Esta solución proporciona una arquitectura de referencia para la indexación escalable de RAG, lo que permite a los equipos consumir datos variados y construir aplicaciones avanzadas que respondan preguntas complejas utilizando la base de conocimiento integrada. El proceso involucra la ingestión, transformación, vectorización, y gestión de índices.

La preparación de datos, crucial para un funcionamiento responsable de RAG, se concentra en limpiar y normalizar los documentos para mejorar la exactitud de los resultados. Además, se implementan consideraciones éticas y de privacidad al filtrar cuidadosamente la información. La solución utiliza Amazon Comprehend y AWS Glue para detectar y sanear datos sensibles antes de procesar los documentos con Spark, dividiendo la información en fragmentos manejables que pueden convertirse en incrustaciones para luego almacenarse en un índice vectorial.

Esta novedosa técnica de procesamiento no solo es innovadora, sino que permite una personalización flexible del procesamiento de datos, asegurando la calidad de los mismos y manteniendo su relevancia en contextos específicos. Además, con tecnologías como Apache Spark y Amazon SageMaker, es posible alcanzar un balance adecuado entre latencia y eficiencia de costos para las búsquedas semánticas, crucial para tareas donde la rapidez y precisión son esenciales.

En definitiva, la implementación de RAG expandida para abarcar grandes volúmenes de datos externos es un avance significativo en el campo de la inteligencia artificial, transformando la manera en que los modelos de lenguaje pueden integrarse y hacer uso de información externa para ofrecer soluciones más precisas y contextualmente relevantes.

vía: AWS machine learning blog