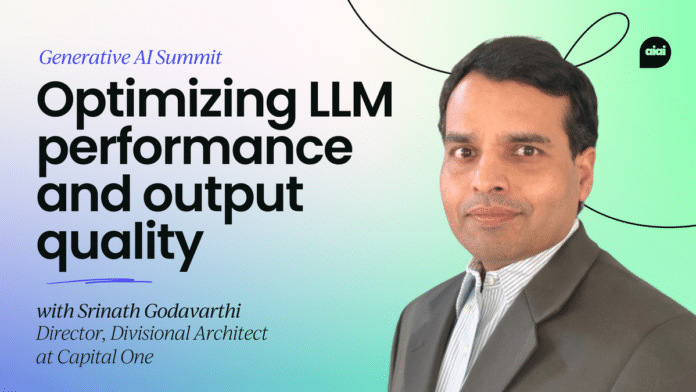

En una reciente sesión dirigida por Srinath Godavarthi, Director y Arquitecto Divisional en Capital One, se abordó la optimización del rendimiento y la calidad de salida de la inteligencia artificial generativa, con el objetivo de mejorar los resultados tanto para clientes como para empresas. El enfoque principal de la charla fue la relevancia de los modelos base, así como los desafíos que enfrentan, incluyendo la variabilidad en la calidad de los resultados y las «alucinaciones» provocadas por datos de entrenamiento ruidosos.

Durante la discusión, Godavarthi presentó cuatro estrategias clave para mejorar el rendimiento de los modelos: el diseño de prompts, la generación aumentada de recuperación (RAG), el ajuste fino y la construcción de modelos desde cero. Cada uno de estos enfoques tiene sus propias ventajas. Por ejemplo, el diseño de prompts permite mejoras rápidas, mientras que el ajuste fino proporciona adaptaciones especializadas para tareas concretas. La elección de la estrategia adecuada dependerá del caso de uso específico y de la complejidad involucrada en el mismo.

Este enfoque analítico resalta la necesidad de abordar los problemas inherentes a la inteligencia artificial generativa, al tiempo que ofrece soluciones prácticas para maximizar su efectividad en diversas aplicaciones.

vía: AI Accelerator Institute