La implementación de sistemas de inteligencia artificial generativa como servicio (SaaS) ha adquirido un papel crucial en la economía digital actual. Sin embargo, lograr un equilibrio entre la escalabilidad del servicio y la gestión de costos se convierte en un desafío, especialmente al diseñar un servicio generativo de múltiples inquilinos que atienda a una base de clientes diversa, manteniendo al mismo tiempo rigurosos controles de costos y un monitoreo exhaustivo del uso.

Las metodologías tradicionales para el manejo de costos en este tipo de sistemas suelen mostrar limitaciones significativas. Los equipos de operaciones enfrentan dificultades para atribuir de manera precisa los costos a cada inquilino, sobre todo cuando los patrones de uso presentan variaciones extremas. Los clientes empresariales pueden tener comportamientos de consumo diferentes, algunos experimentando picos de uso repentinos durante períodos punta, mientras que otros muestran patrones de consumo más estables.

Para abordar estos desafíos, se propone una solución robusta que requiere un sistema de alertas dinámico y contextualizado, que supere los estándares convencionales de monitoreo. La implementación de niveles de alerta graduados — desde verde (operaciones normales) hasta rojo (intervenciones críticas) — permite desarrollar respuestas automáticas e inteligentes que se adaptan a los patrones de uso cambiantes. Esto no solo ayuda a prevenir sobrecostos, sino que también permite una gestión proactiva de los recursos y una asignación precisa de los costos.

El punto de quiebre suele llegar cuando se detectan importantes sobrecostos. Estos no son consecuencia de un único factor, sino de la combinación de múltiples inquilinos que aumentan su uso sin que los sistemas de monitoreo logren identificar la tendencia con antelación. Por lo tanto, los sistemas de alertas existentes, que generalmente proporcionan notificaciones binarias, pueden resultar insuficientes. La situación se complica aún más si se aplica un modelo de precios escalonados que varía de acuerdo a los compromisos y cuotas de uso. Sin un sistema de alertas sofisticado capaz de diferenciar entre picos normales de uso y verdaderos problemas, los equipos de operaciones podrían verse obligados a actuar de manera reactiva en lugar de proactiva.

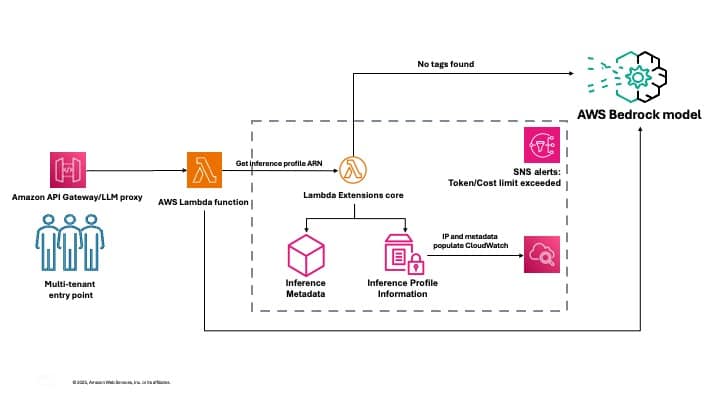

Para facilitar la gestión efectiva de costos en despliegues de inteligencia artificial generativa multiinquilino, se ha desarrollado un enfoque que utiliza los perfiles de inferencia de la aplicación de Amazon Bedrock. Estos perfiles permiten un seguimiento detallado de los costos asociando metadatos con cada solicitud de inferencia, creando una separación lógica entre diferentes aplicaciones o clientes que acceden a los modelos fundamentales. Al emplear una estrategia de etiquetado consistente, se puede rastrear sistemáticamente qué inquilino es responsable de cada llamada a la API y su correspondiente consumo.

La arquitectura de la solución propuesta permite recoger y agregar datos de uso de manera efectiva, almacenar métricas históricas para el análisis de tendencias y presentar percepciones prácticas a través de paneles intuitivos. Este sistema complejo de monitoreo brinda la visibilidad y el control necesarios para gestionar los costos asociados a Amazon Bedrock, todo mientras se mantienen opciones de personalización para ajustarse a las necesidades específicas de la organización.

Implementar esta solución no sólo ayuda a rastrear el uso de modelos, sino que también proporciona la capacidad de asignar costos con precisión y optimizar el consumo de recursos entre diferentes inquilinos. Realizar ajustes y desarrollos adicionales en función de la retroalimentación y los patrones de uso observados permitirá alcanzar una administración más efectiva y eficiente de los recursos en el entorno de inteligencia artificial generativa.

vía: AWS machine learning blog