La creciente implementación de la inteligencia artificial (IA) está revolucionando la forma en que las empresas interactúan con sus clientes, mejorando notablemente la experiencia del usuario a través de múltiples canales. Herramientas como la comprensión del lenguaje natural (NLU) permiten a los negocios identificar las intenciones de los clientes, facilitando así acciones de autoservicio más eficaces. Por otra parte, el reconocimiento automático de voz (ASR) transforma las palabras habladas en texto, lo que posibilita interacciones por voz sin problemas. Los chatbots de Amazon Lex utilizan estas tecnologías para integrar capacidades de IA conversacional en los centros de atención telefónica, comprendiendo las necesidades del cliente y orientándolo a través de su proceso.

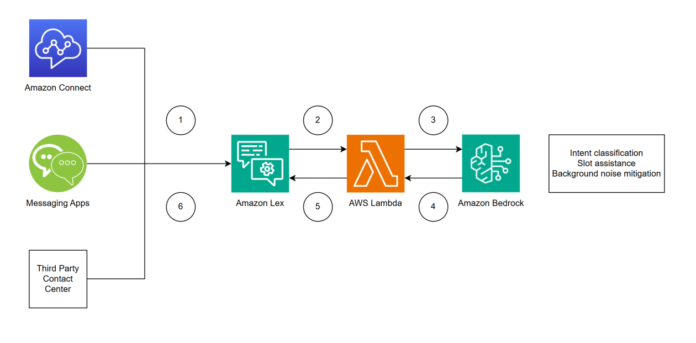

El auge de la IA generativa amplía aún más el horizonte para mejorar las experiencias multicanal. Sin embargo, las preocupaciones en torno a la seguridad, el cumplimiento normativo y las alucinaciones de la IA a menudo desaniman a las empresas a exponer a los clientes a modelos de lenguaje extensos (LLMs) directamente a través de sus soluciones omnicanal. Aquí es donde se vuelve esencial la integración de Amazon Lex y Amazon Bedrock. En este esquema, Amazon Lex actúa como el primer punto de contacto, gestionando la clasificación de intenciones, la recolección de datos y el cumplimiento de los mismos, mientras que Amazon Bedrock funciona como una capa de validación adicional, interviniendo cuando Amazon Lex enfrenta incertidumbres sobre las entradas del cliente.

La interacción entre clientes y negocios puede optimizarse en varios escenarios concretos donde los LLMs tienen un papel crucial. Por ejemplo, en situaciones en las que un cliente expresa su intención de manera clara, pero el modelo tradicional no cuenta con datos de entrenamiento suficientes, como al informar sobre una inundación en una vivienda. En otros casos, el LLM puede ayudar a resolver datos de campo de manera personalizada, interpretando frases que normalmente no se ajustan a las categorías predefinidas. Además, la mitigación de ruido de fondo se presenta como una solución para los llamadores que no pueden controlar el entorno acústico, permitiendo que la NLU distinga entre el ruido y el mensaje del cliente.

El avance en la interacción del cliente es notable al integrar estas capacidades en soluciones de centros de contacto, como Amazon Connect. Combinando las funciones de Amazon Lex, Amazon Bedrock y Amazon Connect, las empresas pueden brindar una experiencia más fluida e inteligente a sus clientes, ya sea a través de voz o chat. El proceso implica que Amazon Connect maneje la comunicación inicial, mientras que Amazon Lex procesa las entradas del cliente y, si es necesario, utiliza Bedrock para una comprensión más profunda.

Para quienes se interesen en implementar esta solución, se presenta una guía para desplegar un chatbot omnicanal utilizando Amazon Lex y Bedrock. Este sistema permite que los clientes proporcionen respuestas no convencionales y logra clasificaciones de intenciones y slot de manera más precisa, al tiempo que se minimizan las repeticiones innecesarias. En un contexto donde la satisfacción del cliente es primordial, estas tecnologías emergentes están redefiniendo las expectativas de servicio dentro del ámbito empresarial.

vía: AWS machine learning blog