La elección del modelo de lenguaje adecuado para una aplicación específica se ha convertido en una tarea cada vez más compleja y esencial para las organizaciones. Muchas veces, los equipos se basan en evaluaciones ad hoc, utilizando muestras limitadas de modelos de moda, y emitiendo juicios de calidad basados simplemente en impresiones personales. Este enfoque puede llevar a decisiones irreflexivas, ya que el análisis informal de las respuestas de los modelos a menudo no detecta errores sutiles ni comportamientos inseguros.

Un enfoque más completo implica evaluar el modelo utilizando métricas cualitativas y cuantitativas, como la calidad de las respuestas, el costo y el rendimiento. Sin embargo, los sistemas de evaluación actuales no escalan lo suficiente para permitir que las organizaciones aprovechen al máximo las opciones de modelos disponibles. Por ello, es crucial contar con un proceso de evaluación estructurado que ayude a las empresas a tomar decisiones informadas a la hora de seleccionar el modelo más adecuado para sus necesidades.

La evaluación basada en «sensaciones» tiene limitaciones significativas. En primer lugar, puede estar influenciada por sesgos subjetivos, ya que los evaluadores pueden preferir respuestas que les parezcan más estilísticamente atractivas en lugar de objetivamente precisas. Además, una evaluación limitada a unos pocos ejemplos interactivos no abarca la complejidad de las entradas del mundo real, lo que hace que se pierdan casos extremos que podrían revelar debilidades importantes en el modelo. También existe el riesgo de inconsistencia entre evaluadores que utilizan diferentes criterios de prioridad. Sin un marco de referencia claro, puede resultar complicado alinear la elección del modelo con los objetivos comerciales de la organización.

Por otra parte, aunque benchmarks establecidos como MMLU y HellaSwag son útiles para ofrecer evaluaciones estandarizadas en aspectos como el razonamiento y la recuperación de información, se centran en el rendimiento general en lugar del dominio específico. Este hecho puede provocar que un modelo con alta clasificación en trivia sea poco efectivo en contextos donde se requiere un dominio específico de terminología, lo que podría resultar en respuestas incorrectas o excesivamente largas.

Para estructurar adecuadamente la evaluación, es necesario considerar múltiples dimensiones, entre ellas:

- Precisión: ¿El modelo produce información precisa y relevante?

- Latencia: ¿Con qué rapidez genera el modelo una respuesta? Esto es crucial en aplicaciones interactivas.

- Eficiencia de costos: ¿Cuál es el costo monetario por cada llamada a la API?

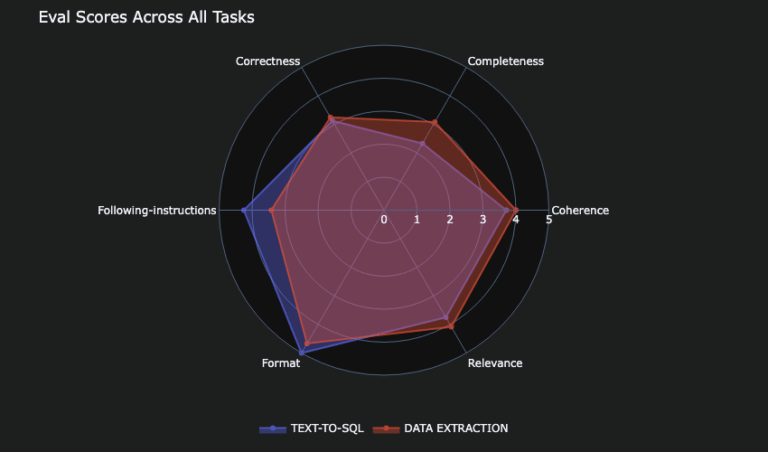

Un marco de evaluación robusto no solo mejora la confianza en el modelo, sino que también permite un análisis más granulado. A medida que los líderes tecnológicos utilicen métodos de evaluación que combinen métricas cuantitativas con juicios cualitativos, podrán lograr evaluaciones más efectivas. La estructura debe incluir un conjunto de criterios diversos, como la corrección, la completitud, la relevancia y la coherencia, lo que valida aún más la calidad de las respuestas.

La nueva iniciativa 360-Eval busca automatizar estos procesos de evaluación, ofreciendo una herramienta que captura la profundidad y amplitud del rendimiento del modelo. Este marco permite que organizaciones como AnyCompany evalúen diferentes modelos de LLM de manera integrada, aplicando una variedad de criterios que no solo resaltan la precisión, sino que también analizan el costo y la eficiencia.

Como caso práctico, AnyCompany está desarrollando una solución SaaS que mejora la arquitectura de bases de datos para desarrolladores. La herramienta debe recibir requisitos en lenguaje natural y generar automáticamente modelos de datos específicos para PostgreSQL. La organización está evaluando varios modelos de lenguaje para asegurar que la respuesta sea rápida y rentable, sin sacrificar la calidad necesaria.

Al final, la elección del modelo se basó en la capacidad de satisfacer los criterios de rendimiento, coste y precisión. Este enfoque permite a las organizaciones no solo hacer elecciones informadas, sino también adaptarse rápidamente a las necesidades cambiantes del mercado. Con la evolución rápida de la inteligencia artificial generativa, contar con una infraestructura de evaluación sólida será esencial para encontrar el modelo adecuado para cada caso de uso específico.

vía: AWS machine learning blog