El ajuste fino de modelos de lenguaje grandes (LLM) preentrenados ha cobrado relevancia, permitiendo a los usuarios personalizar estos modelos para que se desempeñen mejor en tareas específicas. Este proceso es continuo, ya que asegura que el modelo refinado mantenga su precisión y efectividad en entornos cambiantes, adaptándose a la evolución de los datos y evitando la degradación del rendimiento a lo largo del tiempo. La fine-tuning continuo facilita la integración de la retroalimentación humana, permite corregir errores y adapta los modelos a aplicaciones del mundo real.

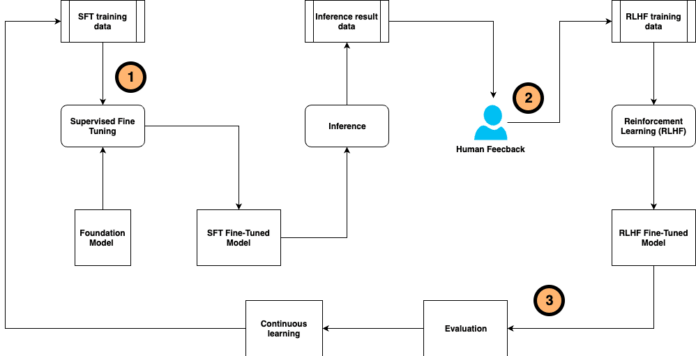

Una técnica que se utiliza en este contexto es el ajuste fino supervisado (SFT) y la afinación de instrucciones, que se basa en conjuntos de datos y directrices anotadas por humanos. A medida que se recibe retroalimentación sobre las respuestas generadas por el modelo, se puede aplicar el aprendizaje por refuerzo basado en la retroalimentación humana (RLHF) para guiar las respuestas del LLM, recompensando las salidas que se alinean con las preferencias humanas.

Sin embargo, obtener resultados precisos y responsables de modelos LLM finamente ajustados exige un esfuerzo considerable por parte de expertos en la materia. La anotación manual de un gran volumen de datos para el ajuste fino y la recolección de comentarios del usuario representan tareas que consumen muchos recursos y tiempo. Además, el proceso continuo de ajuste fino requiere coordinar múltiples pasos que incluyen la generación de datos, el entrenamiento del LLM, la recolección de retroalimentación y la alineación de preferencias.

Para abordar estos retos, se ha desarrollado un marco innovador de ajuste fino auto-instruido continuo. Este sistema simplifica el proceso de ajuste fino del LLM al unificar la generación y anotación de datos de entrenamiento, el entrenamiento y evaluación del modelo, además de la recolección de retroalimentación humana y la alineación con las preferencias de los usuarios. Este enfoque se presenta como un sistema de IA compuesto que busca mejorar la eficiencia del flujo de trabajo para el perfeccionamiento del rendimiento, la versatilidad y la reutilización.

El marco de ajuste fino auto-instruido continuo impulsa un flujo de trabajo para personalizar el modelo base utilizando muestras de entrenamiento etiquetadas por humanos y la retroalimentación humana después de la inferencia del modelo. Este flujo de trabajo opera de manera continua para adaptarse a un entorno cambiante.

En relación con este enfoque, el sistema de IA compuesto ha sido diseñado para superar las complicaciones que presentan los modelos monolíticos. Aquí, la interacción entre múltiples componentes, como llamadas a diversos modelos, recuperadores y herramientas externas, permite la creación de soluciones más sofisticadas y eficientes.

Para facilitar la construcción y optimización de estos sistemas compuestos, se ha introducido DSPy, un marco de programación de Python de código abierto que ayuda a los desarrolladores a crear aplicaciones LLM utilizando programación modular y declarativa. Este marco se encuentra diseñado para optimizar los resultados y la experiencia del usuario en aplicaciones de IA, permitiendo mayor flexibilidad en el desarrollo y mantenimiento de soluciones.

En conclusión, el desarrollo de un sistema de ajuste fino continuo y auto-instruido no solo mejora la precisión y el rendimiento de los modelos de lenguaje, sino que también establece un marco que maximiza la reutilización y la adaptabilidad ante la evolución constante de los datos y las demandas del usuario.

vía: AWS machine learning blog