Amazon ha lanzado nuevas funciones de evaluación de modelos en Amazon SageMaker AI, diseñadas para mejorar la capacidad de los usuarios de evaluar sus modelos de aprendizaje automático de manera más efectiva. Esta actualización incluye el soporte para métricas personalizadas, pruebas de preferencia basadas en LLM, captura de probabilidades logarítmicas, análisis de metadatos y escalado en múltiples nodos para evaluaciones a gran escala.

Entre las características destacadas se encuentran las capacidades de métricas personalizadas que permiten a los desarrolladores definir criterios de evaluación específicos ajustados a sus requisitos. Por ejemplo, se pueden implementar métricas que evalúen la empatía en un modelo de servicio al cliente o la precisión clínica en un asistente médico. Este enfoque ofrece a los equipos la flexibilidad necesaria para adaptar las evaluaciones a sus dominios.

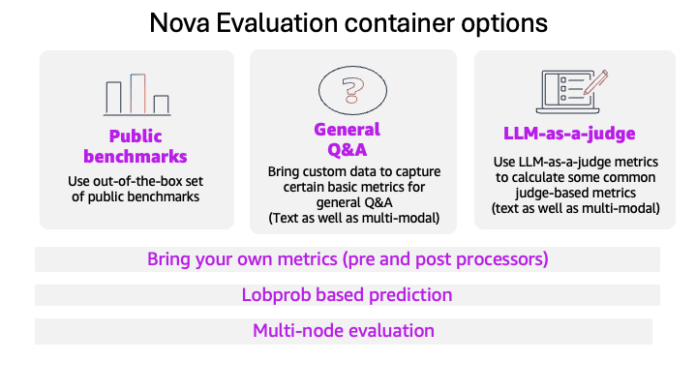

La función “LLM-as-a-Judge” permite realizar evaluaciones subjetivas mediante comparaciones entre pares y reportes sobre qué respuesta es preferida, junto con las razones de cada juicio. Esta metodología es particularmente útil para tareas con razonamientos complejos, donde las explicaciones son tan importantes como la clasificación en sí misma.

Además, la captura de probabilidades logarítmicas proporciona información sobre la confianza del modelo en cada token emitido, lo cual es fundamental para estudios de calibración y decisiones informadas sobre el enrutamiento de respuestas. Los equipos pueden analizar cómo estas probabilidades se correlacionan con el rendimiento real, lo que permite implementar umbrales de calidad y detectar problemas antes de impactar en los sistemas de producción.

Las mejoras en el análisis de metadatos permiten conservar campos adicionales para analizar resultados por segmentos de clientes, dominios, niveles de dificultad y prioridades, sin necesidad de procesamiento adicional. Esto facilita un análisis más rico y detallado de los resultados de las evaluaciones.

Para los equipos que requieren evaluar grandes volúmenes de datos, la nueva función de ejecución en múltiples nodos permite distribuir cargas de trabajo y escalar desde miles hasta millones de ejemplos, garantizando al mismo tiempo una agregación estable y resultados consistentes.

A través de Amazon SageMaker, los equipos pueden definir evaluaciones usando archivos JSONL almacenados en Amazon S3 y ejecutarlas como trabajos de entrenamiento de SageMaker, controlando los flujos de trabajo de pre y post-procesamiento y recibiendo resultados estructurados que se pueden integrar fácilmente en herramientas de análisis como Amazon Athena y AWS Glue. Esta integración establece un camino claro para que las empresas adopten tecnologías de inteligencia artificial generativa de manera más efectiva.

vía: AWS machine learning blog