A medida que las organizaciones incorporan la inteligencia artificial generativa, surgen desafíos críticos en la alineación de estas aplicaciones con sus salvaguardias diseñadas. Aunque los modelos fundamentales (FMs) ofrecen capacidades poderosas, también pueden presentar riesgos únicos, como la generación de contenido dañino, la exposición a información sensible, vulnerabilidades a ataques de inyección de instrucciones y la producción de alucinaciones por parte del modelo.

Para abordar estos desafíos, Amazon Bedrock Guardrails ha demostrado ser un aliado valioso para diversas organizaciones, incluidas MAPFRE, KONE, Fiserv y PagerDuty. Al igual que las aplicaciones tradicionales requieren de seguridad en múltiples capas, esta solución de Amazon implementa salvaguardias esenciales a lo largo de los niveles de modelo, solicitud y aplicación, bloqueando hasta un 88% más de contenido multimodal indeseable y dañino. Además, ayuda a filtrar más del 75% de las respuestas alucinadas en casos de generación aumentada de recuperación y en resúmenes, posicionándose como la primera solución en utilizar razonamiento automatizado para prevenir errores fácticos derivados de alucinaciones.

Un caso de uso particularmente destacado es el de un asistente de inteligencia artificial diseñado para optimizar las interacciones de los asegurados con la compañía de seguros de salud. Gracias a esta solución, los asegurados pueden verificar detalles de cobertura, presentar reclamos, encontrar proveedores dentro de la red y comprender sus beneficios a través de interacciones conversacionales naturales. Esta asistencia está disponible durante todo el día y gestiona consultas rutinarias, lo que permite que los agentes humanos se concentren en casos más complejos. La implementación de Amazon Bedrock Guardrails añade una capa crítica de seguridad y cumplimiento, ayudando a mantener altos estándares en la protección contra contenido indeseable y fomentando la confianza en el sistema de IA.

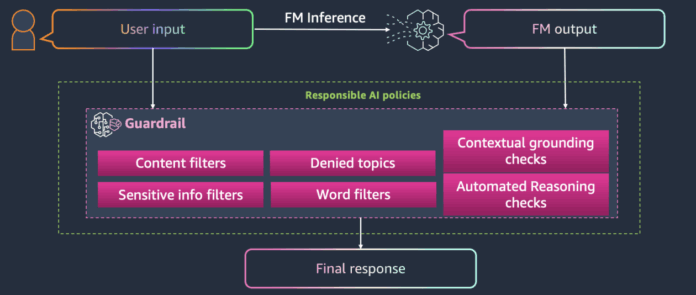

La flexibilidad de Amazon Bedrock Guardrails permite la configuración de salvaguardias ajustadas a las necesidades específicas de cada aplicación. Estas herramientas evaluan las entradas del usuario y las respuestas del modelo basadas en políticas definidas, trabajando con todos los modelos de lenguaje grande (LLMs) en Amazon Bedrock y modelos ajustados, lo que brinda a las organizaciones la capacidad de aplicar múltiples salvaguardias a través de diferentes aplicaciones.

La configuración de políticas de protección específicas, como filtros de contenido multimodal y denegación de temas, se lleva a cabo de manera clara para garantizar que las aplicaciones se mantengan dentro de límites apropiados. Por ejemplo, en el ámbito de los seguros de salud, se evitan consultas sobre diagnósticos de enfermedades, reservando este tipo de evaluaciones para profesionales calificados. Esto no solo reduce riesgos, sino que también contribuye a un entorno más seguro y profesional para los usuarios.

Amazon Bedrock Guardrails ofrece la posibilidad de utilizar la API ApplyGuardrail para evaluar entradas y respuestas sin necesidad de invocar un modelo, lo que proporciona una mayor versatilidad al gestionar la inteligencia artificial generativa. Las pruebas realizadas con distintas consultas demuestran su capacidad para bloquear contenido sensible y proteger la privacidad de los usuarios.

Finalmente, al implementar Amazon Bedrock Guardrails, las organizaciones pueden avanzar hacia un uso más seguro y ético de la inteligencia artificial, destacando su compromiso con la responsabilidad y la seguridad en sus operaciones. Este enfoque no solo mejora la experiencia del cliente, sino que también sienta las bases para una adopción más amplia de tecnologías de inteligencia artificial en sectores críticos como el de la salud.

vía: AWS machine learning blog