Los modelos de lenguaje de gran tamaño (LLMs) se han convertido en una herramienta crucial para diversas aplicaciones en múltiples industrias, desde la mejora de interacciones con clientes hasta la automatización de procesos empresariales. Sin embargo, desplegar estos modelos en escenarios del mundo real plantea importantes desafíos, especialmente en áreas como la precisión, la equidad, la relevancia y la mitigación de alucinaciones (el fenómeno en el que un modelo genera información incorrecta o engañosa). Por ello, una evaluación exhaustiva del rendimiento y las salidas de estos modelos es fundamental para mantener la confianza y la seguridad en su uso.

La evaluación desempeña un papel central en el ciclo de vida de las aplicaciones de inteligencia artificial generativa, similar a lo que ocurre en el aprendizaje automático tradicional. Contar con metodologías de evaluación robustas permite tomar decisiones informadas sobre la elección de modelos y prompts. Sin embargo, la evaluación de los LLMs es un proceso complejo y que consume muchos recursos debido a su capacidad para generar texto libre. Métodos como la evaluación humana ofrecen valiosos insights, pero son costosos y difíciles de escalar. Esto ha llevado a una creciente demanda de marcos de evaluación automatizados que sean altamente escalables y que se puedan integrar en el desarrollo de aplicaciones, similar a las pruebas unitarias y de integración en el desarrollo de software.

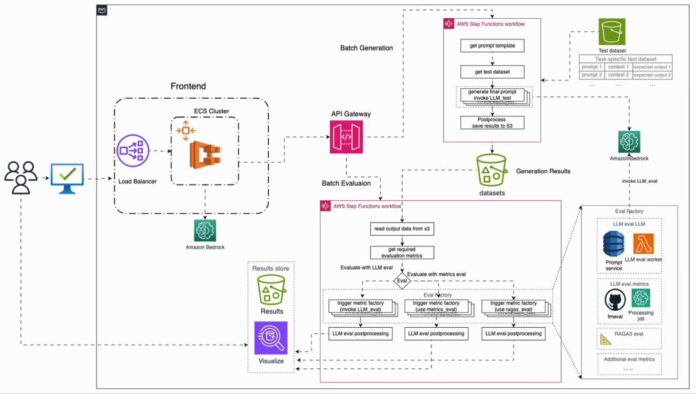

Para abordar estos desafíos, se ha introducido un marco de evaluación automatizado que se puede desplegar en AWS. Este sistema permite la integración de múltiples LLMs, el uso de métricas de evaluación personalizadas y la monitorización continua del rendimiento de los modelos. Se presentan métricas de evaluación de tipo «LLM como juez» utilizando los nuevos modelos de Amazon Nova, que ofrecen evaluaciones escalables gracias a sus avanzadas capacidades y baja latencia. Además, se proporciona una interfaz amigable para facilitar su uso.

Antes de implementar procesos de evaluación para soluciones de inteligencia artificial generativa, es crucial establecer métricas y criterios claros para la evaluación, así como reunir un conjunto de datos representativos. Este conjunto debe incluir muestras diversas y, si es posible, valores de verdad generados por expertos. El tamaño del conjunto de datos dependerá de la aplicación específica, pero debe abarcar casos relevantes y diversos. El desarrollo de este conjunto puede ser un proceso iterativo, mejorado continuamente con nuevas muestras y enriquecido con ejemplos donde el rendimiento del modelo sea deficiente.

Las métricas de evaluación se pueden clasificar en tres grandes áreas. Las métricas basadas en latencia incluyen medidas como el tiempo de generación de respuesta. El costo se refiere al gasto asociado con la generación de respuestas. Las métricas de rendimiento son altamente dependientes del caso y pueden incluir mediciones de precisión y consistencia fáctica de las respuestas generadas.

La evaluación de un modelo se puede llevar a cabo mediante un flujo de trabajo típico que incluye tanto evaluaciones en línea, manuales y cualitativas, como evaluaciones automatizadas en lotes y cuantitativas. Este enfoque podría agregar dificultades operativas significativas, lo que hace necesario contar con herramientas de comparación, servicios de gestión de prompts y servicios de inferencia a gran escala, entre otros.

Con la introducción de un sistema de evaluación automatizada de IA generativa en AWS, se busca simplificar el proceso de evaluación, mejorando así la productividad de los equipos durante el ciclo de desarrollo. Esta solución no solo permite una evaluación eficaz de los modelos de LLM en producción, sino que garantiza que las soluciones de inteligencia artificial generativa se mantengan actualizadas y optimizadas para cumplir con los estándares de precisión, equidad y relevancia.

vía: AWS machine learning blog