Los modelos de lenguaje de gran tamaño (LLMs, por sus siglas en inglés) han transformado el procesamiento del lenguaje natural gracias a su capacidad para comprender y generar textos que imitan el lenguaje humano. Entrenados con amplios conjuntos de datos que abarcan múltiples temas y dominios, estos modelos están siendo adaptados cada vez más para mejorar su rendimiento en aplicaciones específicas mediante técnicas de ajuste fino y aprendizaje con pocos ejemplos. Sin embargo, estos avanzados modelos requieren una considerable potencia computacional, lo que plantea desafíos para lograr tiempos de respuesta bajos en contextos que exigen inmediatez, como la traducción en tiempo real o asistentes de voz conversacionales.

Investigadores han desarrollado Medusa, un marco que acelera la inferencia de LLMs añadiendo cabezas adicionales para predecir múltiples tokens simultáneamente. En una reciente demostración con Medusa-1, se logró una aceleración en la velocidad de inferencia de aproximadamente dos veces sin sacrificar la calidad del modelo, variando este aumento en función del tamaño del modelo y los datos utilizados. En particular, con un conjunto de datos de prueba, se observó un aumento de 1.8 veces en la velocidad.

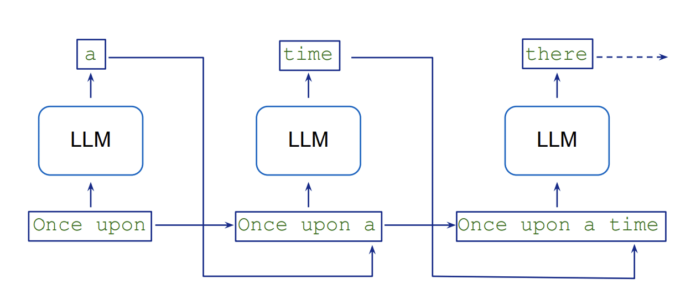

La generación de texto en los LLMs se realiza de manera secuencial, lo que genera un tiempo de latencia inherente, ya que cada nuevo token está condicionado por los anteriores. Este proceso requiere múltiples pasadas del modelo, lo que se traduce en un alto consumo de recursos. La técnica de «decodificación especulativa» busca mitigar esta dificultad utilizando un modelo más ligero para generar múltiples continuaciones potenciales en paralelo, que luego se verifican con un modelo más preciso. A diferencia de este enfoque, Medusa elimina la necesidad de un modelo previo al añadir cabezas de decodificación que generan candidatos simultáneamente, disminuyendo la cantidad de pasos secuenciales requeridos.

El marco Medusa ha demostrado mejoras significativas en términos de velocidad, logrando aumentos de hasta 2.8 veces en la inferencia según el tamaño y la complejidad del modelo. Actualmente, Medusa es compatible con modelos como Llama y Mistral, aunque su implementación puede requerir más memoria en función de la cantidad de cabezas añadidas. Entrenar estas cabezas adicionales demanda tiempo y recursos, lo que debe considerarse en la planificación de proyectos. Por otro lado, el marco solo admite un tamaño de lote de uno, lo que lo hace ideal para aplicaciones que requieren baja latencia.

A través de una serie de pasos orientados, desde la preparación de conjuntos de datos hasta la implementación en un endpoint de Amazon SageMaker AI, se puede acelerar la inferencia de LLMs en aplicaciones, logrando tiempos de respuesta más rápidos y mejorando la experiencia del usuario. A medida que las empresas continúan explorando el potencial de LLMs, la optimización de su performance mediante soluciones como Medusa será crucial para enfrentar los desafíos operativos y de calidad en la generación de texto automatizada.

vía: AWS machine learning blog