En la esfera en rápida evolución de la inteligencia artificial (IA), la capacidad de personalizar modelos de lenguaje para industrias específicas se ha convertido en una prioridad. Aunque los modelos de lenguaje de gran tamaño (LLMs, por sus siglas en inglés) son hábiles en manejar una variedad amplia de tareas con lenguaje natural, su fortaleza reside en tareas de propósito general más que en tareas especializadas. Esta desarmonía puede presentar desafíos al procesar datos textuales provenientes de dominios altamente especializados que tienen terminología propia, o en tareas específicas donde el conocimiento intrínseco del LLM no es apto para soluciones como la Generación Aumentada por Recuperación (RAG).

Un ejemplo se encuentra en la industria automotriz, donde los usuarios no siempre proporcionan códigos de diagnóstico específicos (DTCs), que suelen ser exclusivos de cada fabricante. Códigos como P0300 para un fallo de encendido genérico en el motor, o C1201 para un fallo en el sistema ABS, son esenciales para un diagnóstico preciso. Sin estos códigos, un LLM de propósito general podría tener dificultades para ofrecer información precisa. Esta falta de especificidad puede conducir a alucinaciones en las respuestas generadas, donde el modelo inventa diagnósticos plausibles pero incorrectos, o en algunos casos, no proporcionar respuestas en absoluto. Por ejemplo, si un usuario describe simplemente «motor funcionando de manera irregular» sin proporcionar el DTC específico, un LLM podría sugerir una amplia gama de problemas potenciales, algunos de los cuales pueden no ser relevantes para el problema real, o no aportar un diagnóstico significativo debido a la falta de contexto suficiente. Del mismo modo, en tareas como la generación de códigos y sugerencias a través de aplicaciones basadas en chat, los usuarios podrían no especificar las APIs que desean utilizar y, en cambio, podrían requerir ayuda en la resolución de un problema general o en la generación de código que utilice APIs y SDKs propietarios.

Además, las aplicaciones de IA generativa para consumidores pueden ofrecer valiosas percepciones sobre los tipos de interacciones de los usuarios finales. Con los mecanismos de retroalimentación adecuados, estas aplicaciones también pueden recoger datos importantes para mejorar continuamente el comportamiento y las respuestas generadas por estos modelos.

Por estas razones, existe una tendencia creciente en la adopción y personalización de modelos de lenguaje de pequeño tamaño (SLMs). Los SLMs son modelos compactos de transformadores, que utilizan principalmente arquitecturas de decodificador único o codificador-decodificador, típicamente con parámetros que van desde 1 a 8 mil millones. Generalmente, son más eficientes y rentables de entrenar y desplegar comparados con los LLMs, y son altamente efectivos cuando están optimizados para dominios o tareas específicas. Los SLMs ofrecen tiempos de inferencia más rápidos, requieren menos recursos y son adecuados para implementarse en una gama más amplia de dispositivos, haciéndolos particularmente valiosos para aplicaciones especializadas y escenarios de computación en el borde. Además, técnicas más eficientes para personalizar tanto LLMs como SLMs, como la Adaptación de Bajo Rango (LoRA), están haciendo estas capacidades cada vez más accesibles para una gama más amplia de clientes.

AWS ofrece una gama amplia de soluciones para interactuar con modelos de lenguaje. Amazon Bedrock es un servicio totalmente gestionado que ofrece modelos de base de Amazon y otras compañías de AI para ayudar a construir aplicaciones de IA generativa y albergar modelos personalizados. Amazon SageMaker es un servicio completo de machine learning totalmente gestionado para construir, entrenar y desplegar LLMs y otros modelos de base a gran escala. Uno puede afinar y desplegar modelos con Amazon SageMaker JumpStart o directamente a través de contenedores de Hugging Face.

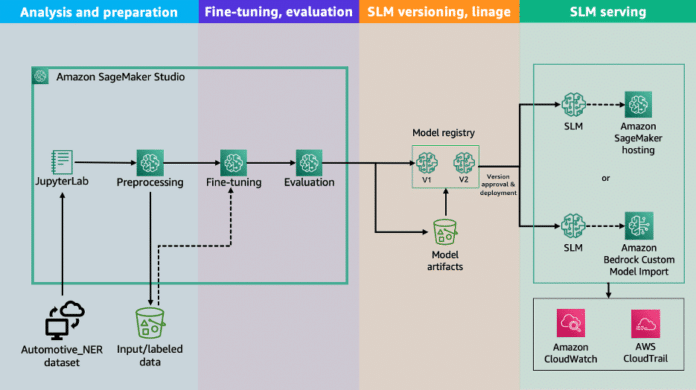

En esta publicación, guiamos a través de las fases de personalización de SLMs en AWS, con un enfoque específico en la terminología automotriz para diagnósticos como tarea de preguntas y respuestas. Comenzamos con la fase de análisis de datos y progresamos a través del proceso completo, cubriendo afinación, implementación y evaluación. Comparamos un SLM personalizado con un LLM de propósito general, utilizando varias métricas para evaluar la riqueza del vocabulario y la precisión general. Proporcionamos una comprensión clara de la personalización de modelos de lenguaje específicos para el dominio automotriz y sus beneficios. Aunque esta publicación se enfoca en el dominio automotriz, los enfoques son aplicables a otros dominios. Se puede encontrar el código fuente de la publicación en el repositorio asociado de Github.

vía: AWS machine learning blog