El equipo de Inteligencia Artificial de Salesforce ha implementado Amazon Bedrock Custom Model Import para optimizar su proceso de despliegue de modelos de lenguaje grande (LLMs). Anteriormente, la gestión de la infraestructura requería extensos esfuerzos que incluían meses de optimización de instancias, motores de servicio y configuraciones, elevando tanto el tiempo como los costos operativos debido a las reservas de capacidad de GPU. Este cambio hacia Amazon Bedrock ha permitido al equipo centrarse más en el desarrollo de modelos y lógica empresarial, aliviando la carga operativa.

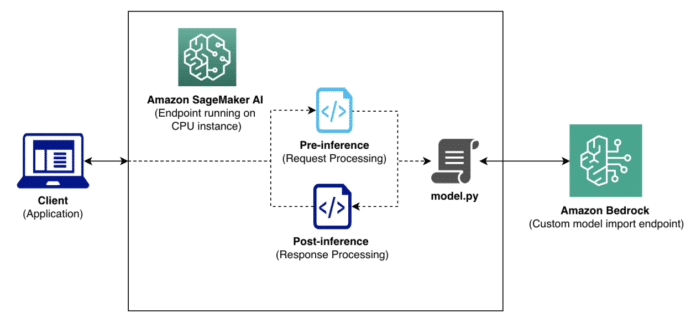

La integración con Amazon Bedrock se realizó cuidadosamente para no interrumpir las cargas de trabajo productivas. Salesforce pudo mantener sus API y las interfaces de servicio de modelos sin cambios, lo que resultó en un despliegue sin tiempo de inactividad. Además, al utilizar la capacidad sin servidor de Amazon Bedrock, la empresa preservó su inversión en infraestructura existente.

La fase de implementación incluyó una mejora en el proceso de entrega de modelos, donde ahora se registra el modelo usando el API de Amazon Bedrock Custom Model Import después de guardar los artefactos del modelo en un bucket de Amazon S3. Esto permite un tiempo de despliegue de aproximadamente 1 hora, con un aumento en la eficiencia, ya que Amazon Bedrock pre-carga los modelos, eliminando la necesidad de descargar pesos al iniciar el contenedor.

Salesforce también completó pruebas de carga para verificar la capacidad de escalabilidad de Amazon Bedrock. Los resultados mostraron que en niveles bajos de concurrencia se alcanzó una latencia un 44% menor en comparación con un modelo base, además de mantener un rendimiento consistente incluso bajo cargas pesadas. Esta capacidad de autoescalado permite que el servicio responda eficazmente a las exigencias de carga en tiempo real.

Desde el punto de vista operativo, Salesforce logró una reducción del 30% en el tiempo necesario para iterar y desplegar modelos, y un ahorro de costos de hasta el 40%, gracias a la flexibilidad de un modelo de pago por uso. Esto ha sido especialmente beneficioso en entornos de desarrollo donde los recursos de GPU solo son necesarios durante períodos activos.

Las lecciones aprendidas durante el proceso resaltan la importancia de validar la compatibilidad del modelo antes de comprometerse al despliegue y considerar el impacto de los tiempos de inicio en modelos más grandes. Para aquellos que buscan simplificar el despliegue de modelos de lenguaje a gran escala, el caso de Salesforce ofrece un marco claro para abordar desafíos operativos y de costo sin comprometer el rendimiento.

vía: AWS machine learning blog