Amazon Bedrock lanzó una nueva funcionalidad denominada Knowledge Bases, diseñada para facilitar la implementación de flujos de trabajo de Generación Aumentada por Recuperación (RAG). Esta capacidad completamente gestionada abarca desde la ingestión hasta la recuperación y la augmentación de prompts, eliminando la necesidad de construir integraciones a medida con fuentes de datos y gestionar flujos de datos. La optimización del rendimiento de las bases de conocimiento no sigue un único camino; cada caso de uso se ve afectado de manera distinta por los parámetros de configuración. Por lo tanto, es crucial realizar pruebas frecuentes y ajustar rápidamente las configuraciones para identificar la mejor opción para cada situación particular.

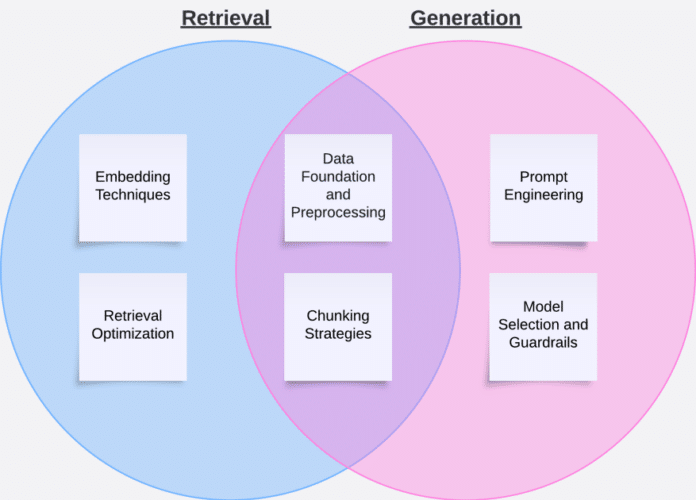

En un reciente artículo, se detallan las distintas etapas para evaluar el rendimiento de una base de conocimiento. Estas etapas incluyen la evaluación independiente del proceso de recuperación y la generación de respuestas. La recuperación implica obtener partes relevantes de documentos basadas en una consulta y añadir estos elementos recuperados como contexto al prompt final. La generación se refiere a enviar el prompt del usuario y el contexto recuperado a un modelo de lenguaje grande (LLM), y luego devolver la salida del LLM al usuario.

Para evaluar la recuperación, se utilizan dos métricas clave: relevancia del contexto, que determina si la información recuperada aborda la intención de consulta, y cobertura del contexto, que mide la exhaustividad de los textos recuperados frente a la verdad objetiva. Ambas métricas se compilan comparando los resultados de búsqueda con las respuestas esperadas dentro de un conjunto de datos de prueba que cumple con formatos específicos.

Una vez validado que el flujo de trabajo de RAG recupera efectivamente el contexto relevante, se puede proceder a la evaluación de la fase de generación. El marco de evaluación de Amazon Bedrock ofrece una evaluación integral que considera ocho métricas que cubren tanto la calidad de la respuesta como criterios de inteligencia artificial responsable. Las métricas de calidad de la respuesta incluyen aspectos como utilidad, corrección, coherencia lógica, completitud y fidelidad. Por otro lado, las métricas de inteligencia artificial responsable evalúan la presencia de contenido dañino, estereotipado y la adecuada negativa a responder preguntas inapropiadas.

Construir un conjunto de datos de prueba robusto es fundamental para una evaluación significativa y se recomienda usar datos anotados por humanos, generación de datos sintéticos utilizando modelos de lenguaje grandes (LLMs) y una estrategia de mejora continua basada en retroalimentación de usuarios. A lo largo del proceso de optimización, se sugiere balancear las técnicas de mejora de rendimiento con un enfoque iterativo que permita ajustes precisos y significativos.

Finalmente, la optimización de las Bases de Conocimiento de Amazon Bedrock es un proceso iterativo que requiere pruebas y refinamientos sistemáticos. El éxito proviene del uso metódico de técnicas como la ingeniería de prompts y el chunking para mejorar tanto la etapa de recuperación como la de generación. Seguir las métricas clave a lo largo de este proceso permitirá medir el impacto de las optimizaciones y garantizar que se cumplan los requisitos de la aplicación.

vía: AWS machine learning blog