La creciente demanda de los clientes por integrar inteligencia artificial generativa en sus negocios ha llevado a múltiples enfoques y soluciones innovadoras. Uno de los métodos más prometedores implica el uso de modelos de lenguaje de gran tamaño preentrenados, como permite el servicio Amazon Bedrock. Este plataforma gestiona modelos de vanguardia de diversas startups de inteligencia artificial y de Amazon a través de una API, permitiendo a las empresas seleccionar el modelo más adecuado para sus necesidades.

Amazon Bedrock no solo brinda acceso a estos modelos, sino que también permite su personalización. Esto es crucial, especialmente para tareas avanzadas o específicas que requieren un formato particular. La personalización se puede realizar mediante técnicas de ajuste fino, lo que implica entrenar un modelo preentrenado utilizando datos cuidadosamente etiquetados para mejorar su rendimiento en un caso de uso concreto. Sin embargo, uno de los desafíos persistentes en este proceso es la dificultad de recopilar datos relevantes y mantener su calidad.

Para abordar esta problemática, la generación de datos sintéticos ha emergido como una solución viable. Al crear datos de entrenamiento sintéticos mediante un modelo de lenguaje más grande, se logra un tiempo de respuesta más rápido y se reduce la necesidad de recursos considerables, lo que es especialmente beneficioso en escenarios donde los datos son limitados.

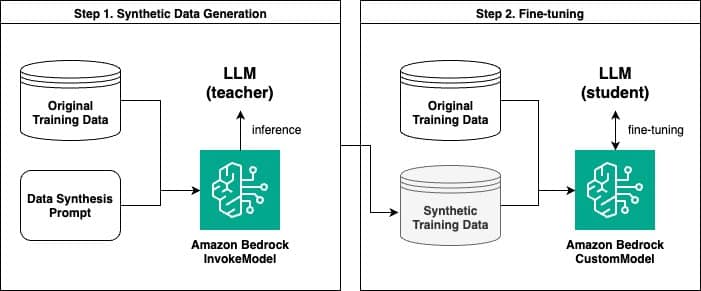

En este contexto, Amazon Bedrock permite a los usuarios generar datos sintéticos y luego afinar modelos de lenguaje a partir de esta información generada. En un reciente estudio, se demostró cómo utilizar Amazon Bedrock para crear datos sintéticos y afinar un modelo de lenguaje. Este proceso consta de dos pasos fundamentales: primero, generar datos sintéticos utilizando la API InvokeModel de Amazon Bedrock, y segundo, realizar el ajuste fino con un modelo personalizado.

El proceso comienza con la generación de pares de preguntas y respuestas sintéticas, donde un modelo de lenguaje más grande actúa como modelo «maestro», proporcionando información y contextos que se utilizan para entrenar un modelo «estudiante» más pequeño. Este enfoque se asemeja a la destilación del conocimiento en el aprendizaje profundo y se ha mostrado eficaz en la mejora del rendimiento del modelo estudiado.

Además, se realizaron evaluaciones comparativas entre modelos afinados con datos originales y aquellos afinados con datos sintéticos. Los resultados mostraron que los modelos afinados con datos sintéticos lograron un rendimiento superior en muchas ocasiones, aunque no siempre superaron aquellos entrenados con cantidades sustanciales de datos originales.

El uso de la evaluación de modelos basada en un «LLM como juez» también se ha implementado, donde un modelo de lenguaje evalúa la calidad de las respuestas generadas por otros modelos. Esta metodología mostró que el modelo afinado con ejemplos sintéticos tenía un rendimiento destacado en comparación con los demás.

En conclusión, el uso de Amazon Bedrock para la generación de datos sintéticos y la posterior personalización de modelos representa una estrategia efectiva para enfrentar la escasez de datos en diversas aplicaciones. A medida que las empresas buscan soluciones más eficientes y rentables en la personalización de modelos de lenguaje, estas innovaciones podrían desempeñar un papel fundamental en su desarrollo y éxito.

vía: AWS machine learning blog