En un contexto donde la inteligencia artificial generativa está en auge, las empresas están buscando cada vez más modelos de fundación adaptados a sus dominios específicos para satisfacer necesidades concretas en áreas como la resumición de documentos, adaptaciones específicas de la industria, y generación y asesoría técnica de códigos. Estos modelos han permitido a las organizaciones ofrecer experiencias personalizadas con un mínimo de conocimientos técnicos, impulsando así la innovación y mejorando sus servicios en diversos sectores, desde el procesamiento del lenguaje natural hasta la generación de contenido.

No obstante, la implementación de estos modelos de IA generativa en entornos empresariales presenta retos únicos. Los modelos disponibles «fuera de la caja» a menudo carecen del conocimiento específico necesario para ciertos dominios o terminologías organizacionales. Para solucionar este problema, las empresas están recurriendo a modelos ajustados a medida, conocidos como modelos de lenguaje grande (LLMs) específicos de dominio. Estos modelos son diseñados para llevar a cabo tareas especializadas dentro de dominios o micro-dominios particulares. Además, se están afinando los modelos de IA generativa en áreas como finanzas, ventas, marketing, IT, recursos humanos, salud y atención al cliente.

Con el creciente interés por soluciones de IA personalizadas y especializadas, las empresas se enfrentan al reto de gestionar de manera eficiente una multiplicidad de modelos ajustados en función de diferentes casos de uso y segmentos de clientes. Desde el análisis de currículos hasta la generación de correos electrónicos específicos de dominio, las compañías a menudo lidian con la gestión de cientos de modelos afinados, lo cual puede resultar costoso y complejo. Las soluciones tradicionales para el alojamiento de modelos pueden volverse difíciles de manejar y consumir muchos recursos, lo que lleva a un aumento en los costos de infraestructura y posibles cuellos de botella en el rendimiento.

Una solución prometedora a estos desafíos es el uso de Low-Rank Adaptation (LoRA), una técnica que permite adaptar de manera eficiente modelos de lenguaje preentrenados a nuevas tareas o dominios mediante la introducción de pequeñas matrices de pesos entrenables. Sin embargo, el enfoque tradicional de hosting de modelos ajustados, que fusiona los capas afinadas con los pesos del modelo base, resulta ineficiente en términos de recursos y costos.

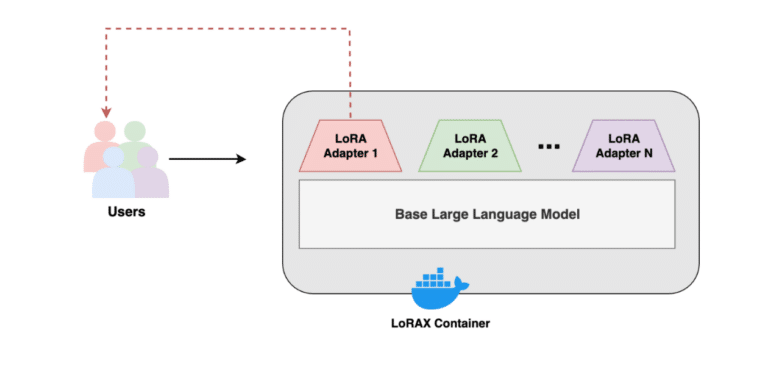

El software de código abierto LoRAX ofrece un mecanismo para intercambiar pesos para la inferencia, permitiendo a las organizaciones gestionar y servir su creciente cartera de modelos afinados de manera más eficiente y rentable. Con LoRAX, las empresas pueden afinar un modelo base para diversas tareas y alojar diferentes variantes en una única instancia de EC2, lo que representa un ahorro significativo sin comprometer el rendimiento.

Esta necesidad de eficiencia ha llevado a la escalada en el uso de LoRAX en AWS, donde se están construyendo diversas soluciones para desplegar adaptadores LoRA. Con el respaldo de una comunidad activa y la capacidad de personalizar integraciones, LoRAX se presenta como una alternativa viable para el despliegue de modelos de IA generativa, especialmente en situaciones donde se requiere un soporte robusto.

En última instancia, la implementación de LoRAX no solo mejora la gestión de modelos a gran escala, sino que también ofrece una evaluación más flexible y controlada de los costos asociados a su uso, permitiendo a las empresas aprovechar al máximo los modelos de fundación para cumplir con sus necesidades específicas en la era digital.

vía: AWS machine learning blog