En los últimos años, las organizaciones del sector salud y ciencias de la vida han comenzado a transformar el descubrimiento de fármacos, los dispositivos médicos y la atención al paciente mediante el uso de agentes de inteligencia artificial generativa. Sin embargo, en industrias altamente reguladas, cualquier sistema que tenga un impacto en la calidad del producto o la seguridad del paciente debe cumplir con las normativas de Buenas Prácticas (GxP), incluyendo Buenas Prácticas Clínicas (GCP), Buenas Prácticas de Laboratorio (GLP) y Buenas Prácticas de Fabricación (GMP). Por lo tanto, es fundamental que las organizaciones demuestren a las autoridades regulatorias que sus agentes de IA son seguros, efectivos y cumplen con los estándares de calidad.

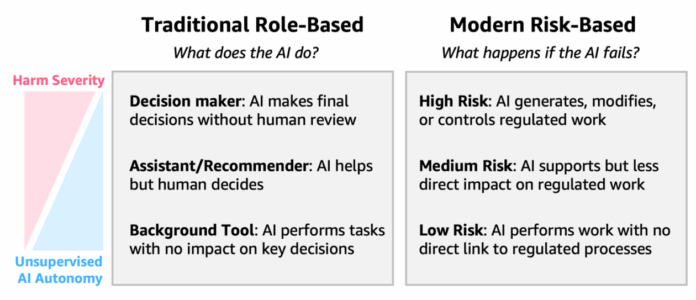

La clave para construir agentes de IA en entornos GxP radica en comprender cómo desarrollarlos adecuadamente en función de sus perfiles de riesgo. La inteligencia generativa presenta desafíos únicos, como la explicabilidad, los resultados probabilísticos y el aprendizaje continuo, lo que exige evaluaciones de riesgo cuidadosas en lugar de enfoques de validación simplificados. La desconexión entre los métodos de cumplimiento tradicionales de GxP y las capacidades modernas de IA crea barreras para la implementación, incrementa los costos de validación y ralentiza la innovación, limitando así los beneficios potenciales en la calidad del producto y la atención al paciente.

El entorno regulatorio para el cumplimiento de GxP está evolucionando para abordar las características únicas de la IA. Las metodologías tradicionales de Validación de Sistemas Informáticos (CSV) están siendo complementadas por marcos de Aseguramiento de Software Informático (CSA) que enfatizan métodos de validación basados en riesgos, adaptados a la complejidad y el impacto real de cada sistema. Esto permite a las organizaciones implementar un enfoque más ágil, ajustado a las necesidades específicas de cada herramienta de IA.

Implementar controles efectivos para sistemas de IA en entornos GxP implica evaluar los riesgos no solo en función de las características tecnológicas, sino también del contexto operativo. La guía del FDA sugiere clasificar los riesgos basados en tres factores: la gravedad del daño potencial, la probabilidad de ocurrencia y la detectabilidad de fallos. Este marco de implementación basado en riesgos permite a las organizaciones equilibrar la innovación con el cumplimiento normativo, personalizando los esfuerzos de validación según niveles de riesgo, en lugar de aplicar controles uniformes a todas las implementaciones de IA.

En este contexto, la solución de AWS se configura como un soporte crucial para la conformidad regulatoria. Proporciona infraestructura calificada y servicios que ayudan a las organizaciones a mantener un enfoque organizado y coherente en sus esfuerzos de cumplimiento. Esto incluye procedimientos bien documentados para la gestión de usuarios y la configuración de roles, que optimizan la gestión de accesos y el mantenimiento de registros.

La correcta implementación de agentes de IA GxP requiere una comprensión clara del modelo de responsabilidad compartida entre los clientes y AWS. Mientras AWS se encarga de la protección de la infraestructura que soporta los servicios en la nube, las organizaciones deben centrarse en proporcionar soluciones eficaces y alineadas con la normativa.

De manera concreta, se destaca la importancia de establecer criterios de aceptación y protocolos de validación adecuados según el uso previsto de los sistemas de IA. A medida que las organizaciones adoptan agentes de IA, deben tener en cuenta tanto su riesgo como el contexto operativo para garantizar que se ajusten a los estándares de GxP mientras fomentan la innovación en el sector salud.

vía: AWS machine learning blog