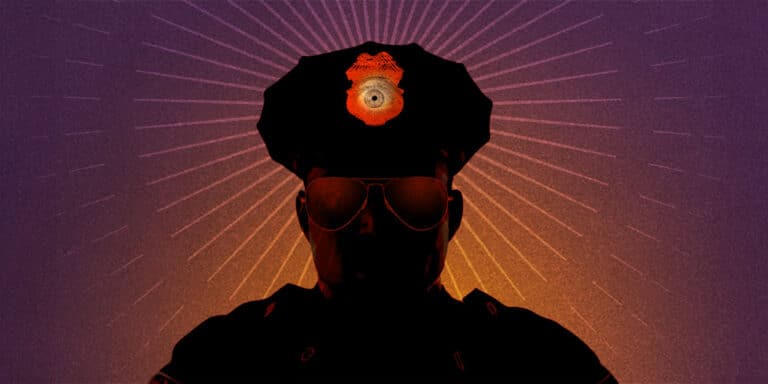

La semana pasada, la Electronic Frontier Foundation (EFF) se unió a 30 grupos de la sociedad civil y académicos para advertir a la Secretaria del Interior del Reino Unido, Yvette Cooper, y al Secretario del Departamento de Ciencia, Innovación y Tecnología, Peter Kyle, sobre los riesgos que conlleva la aplicación de la ley en el borrador del Proyecto de Ley de Uso y Acceso de Datos (DUA Bill).

El artículo 80 del DUA Bill debilita las protecciones para decisiones completamente automatizadas en el contexto de la aplicación de la ley y diluye salvaguardias cruciales para la protección de datos. Según las secciones 49 y 50 de la Ley de Protección de Datos de 2018, en el ámbito de la aplicación de la ley, se prohíbe la toma de decisiones completamente automatizadas a menos que dicha decisión sea requerida o autorizada por la ley. Sin embargo, el artículo 80 revierte esta prohibición en todos los escenarios, a menos que el procesamiento de datos implique datos de categorías especiales.

Esto permitiría a las autoridades emplear decisiones automatizadas sobre individuos basadas en su estado socioeconómico, datos de su región o código postal, emociones inferidas o incluso acentos regionales. Esta situación incrementa las posibilidades de sesgo, discriminación y falta de transparencia por parte de las fuerzas del orden.

En la propia Evaluación de Impacto del gobierno para el DUA Bill, se reconoció que “aquellos con características protegidas, como raza, género y edad, tienen más probabilidades de enfrentar discriminación por parte de la toma de decisiones automatizada debido a sesgos históricos en los conjuntos de datos”. A pesar de esta advertencia, los políticos en el Reino Unido han decidido avanzar con esta agenda discriminatoria y peligrosa.

Además, dada la ya escasa transparencia en torno a la toma de decisiones automatizadas, las personas afectadas en el contexto de la ley tendrían pocas o muy limitadas opciones de reparación. El DUA Bill pone en riesgo a grupos marginados al exponerlos a decisiones automatizadas opacas, injustas y dañinas. Yvette Cooper y Peter Kyle deben abordar la falta de salvaguardias que regulan el uso de herramientas de toma de decisiones automatizadas por parte de las fuerzas del orden antes de que sea demasiado tarde.

Fuente: EFF.org