En los últimos años, la inteligencia artificial generativa ha experimentado avances significativos gracias a las inversiones de diversas empresas en el desarrollo de modelos de lenguaje. Ejemplos destacados incluyen Claude Opus 4 y Sonnet 4 de Anthropic, así como Amazon Nova y Bedrock. Estos modelos están diseñados para razonar, redactar y generar respuestas con una creciente sofisticación. Sin embargo, a pesar de su impresionante capacidad, están limitados por la información a la que tienen acceso, lo que plantea una serie de desafíos para las empresas.

Las empresas suelen enfrentarse a tres problemas críticos: los silos informáticos, que atrapan datos valiosos detrás de APIs personalizadas; la complejidad de integración, que exige mantener conectores y código a medida para cada fuente de datos; y los cuellos de botella en escalabilidad, que surgen al intentar conectar modelos a múltiples sistemas. Estas dificultades han llevado a la necesidad de soluciones más eficientes, como el Protocolo de Contexto de Modelo (MCP).

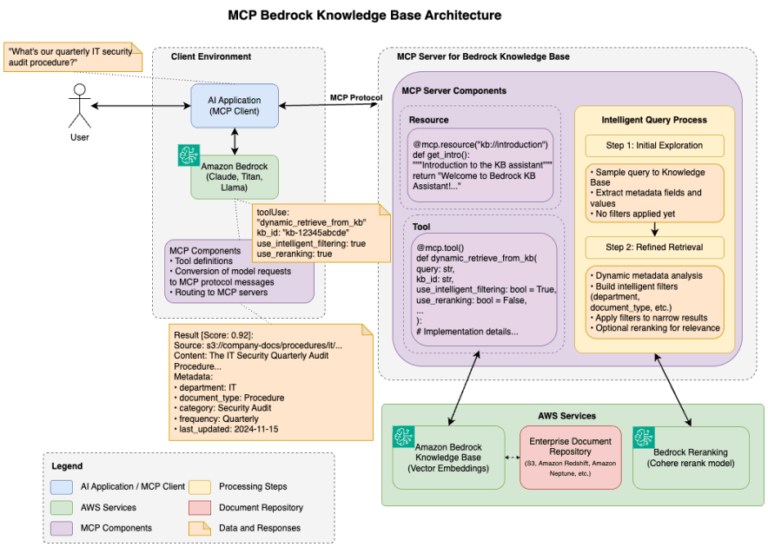

Desarrollado por Anthropic y liberado como un proyecto de código abierto, el MCP establece un lenguaje universal que permite a los sistemas de IA comunicarse con fuentes de datos externas de manera estandarizada. Esta comunicación se realiza a través de una arquitectura cliente-servidor, donde las aplicaciones de IA actúan como clientes que requiren acceso a datos y los servidores MCP ofrecen acceso estandarizado a diversas fuentes de información.

El MCP resuelve el problema de integración M×N, donde M representa aplicaciones de IA y N diferentes fuentes de datos, simplificando el marco de trabajo necesario para la conexión. Con esta arquitectura, las organizaciones pueden construir soluciones de IA escalables y eficientes, aprovechando al mismo tiempo las capacidades de seguridad ya establecidas de AWS, como la gestión de identidad y acceso.

Particularmente relevante para los usuarios de AWS, el MCP permite integrar de manera más fluida los modelos de lenguaje de Amazon Bedrock con los servicios de datos de AWS, lo que se traduce en soluciones más composables y escalables. Esto resulta en una experiencia de usuario que mezcla capacidades de IA con el acceso a datos relevantes, y a su vez, reduce la carga de desarrollo y los costos de mantenimiento.

A futuro, el MCP también está en constante evolución, con nuevas capacidades que se están implementando regularmente. Esto incluye un nuevo nivel de transporte HTTP que promete facilitar despliegues a gran escala, garantizando una integración segura y eficiente entre las aplicaciones de IA y la rica variedad de servicios de AWS.

En resumen, el Protocolo de Contexto de Modelo no solo representa un avance significativo en la manera en que las aplicaciones de IA pueden interactuar con los datos empresariales, sino que también ofrece una hoja de ruta clara para que las organizaciones aprovechen al máximo esta tecnología en el futuro.

vía: AWS machine learning blog