El avance de la inteligencia artificial generativa y los modelos de lenguaje grande (LLMs) está provocando una transformación significativa en las organizaciones de diversos sectores, permitiendo mejorar la experiencia del cliente de manera acelerada en comparación con los métodos tradicionales que requerían años de desarrollo. Cada organización cuenta con una gran cantidad de datos almacenados, ya sea en infraestructuras locales o en proveedores de la nube.

Una forma efectiva de aprovechar la inteligencia artificial generativa es convertir los datos existentes en un índice que esta tecnología pueda utilizar para buscar. A diferencia de los resultados que se obtienen a partir de preguntas a un LLM de código abierto que solo devuelve información disponible públicamente, la inteligencia generativa puede proporcionar un entendimiento más profundo de esos datos, complementando la información con contexto adicional gracias a técnicas como la Generación Aumentada por Recuperación (RAG).

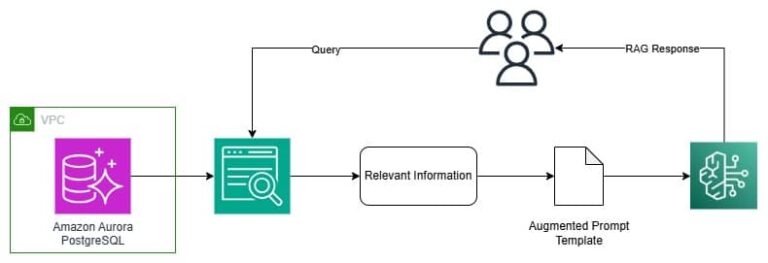

RAG permite extraer datos de una base de conocimiento preexistente (los datos de la organización), los combina con el conocimiento del LLM y produce respuestas que suenan más naturales. Sin embargo, para que la inteligencia generativa entienda los datos de una organización, es necesario realizar cierta preparación de estos, lo que puede suponer una curva de aprendizaje considerable.

Amazon Aurora, una base de datos relacional compatible con MySQL y PostgreSQL, ha sido diseñada para optimizar su uso en la nube. Combinando la eficacia y disponibilidad de bases de datos empresariales tradicionales con la simplicidad y rentabilidad de las bases de datos de código abierto, Aurora se presenta como una solución para transformar los datos en un recurso útil.

Un ejemplo de implementación de esta estrategia consiste en usar los datos existentes en Aurora como fuente para crear un servicio de búsqueda inteligente, conectando y sincronizando esta fuente con Amazon Kendra. A partir de aquí, se puede realizar una búsqueda de datos generativa que utiliza RAG para generar respuestas precisas, basadas en una combinación entre los datos de la organización y el conocimiento de LLMs.

Los pasos para llevar a cabo esta implementación incluyen crear un clúster de Aurora PostgreSQL, ingerir datos en la base de datos, establecer un índice en Amazon Kendra, y configurar un conector de Aurora PostgreSQL en Kendra para vincular ambos sistemas. Una vez que el índice Kendra está sincronizado con los datos de Aurora, se habilita la búsqueda inteligente y la generación de respuestas mejoradas a través de la interacción con la inteligencia artificial.

La implementación de esta tecnología no solo reduce la necesidad de preparar datos antes de ser utilizados por servicios de búsqueda, sino que también acelera el desarrollo de aplicaciones de inteligencia generativa, facilitando a las organizaciones avanzar en su transformación digital y optimización de servicios al cliente.

vía: AWS machine learning blog