ByteDance, una de las compañías líderes en tecnología, ha anunciado avances significativos en su capacidad para entender videos mediante el uso de modelos de lenguaje multimodal (LLMs). La colaboración con Amazon Web Services (AWS) ha permitido a la empresa implementar LLMs que procesan una inmensa cantidad de videos a diario, superando los desafíos tradicionales de análisis de contenido. Este nuevo enfoque no solo mejora la eficiencia, sino que también garantiza que el contenido cumpla con las directrices de la comunidad, proporcionando así una experiencia más segura para los usuarios.

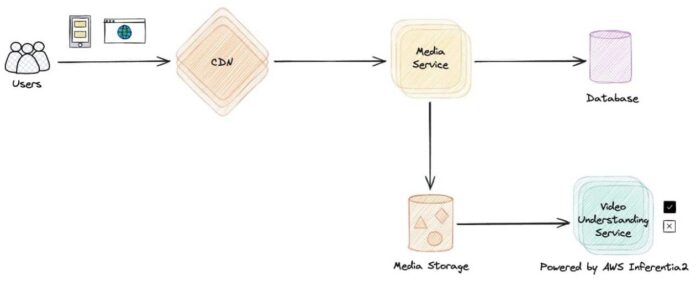

Con una misión centrada en «Inspirar Creatividad y Enriquecer la Vida», ByteDance ha estado desarrollando diversas plataformas de contenido, como CapCut y Mobile Legends: Bang Bang. A través de su motor de aprendizaje automático, la compañía utiliza sofisticados algoritmos para escanear miles de millones de videos, identificando y marcando aquellos que no cumplen con las normas establecidas. Este proceso se ha optimizado considerablemente con la implementación de las instancias Amazon EC2 Inf2, lo que ha permitido reducir a la mitad el costo de la inferencia.

La aplicación de modelos de lenguaje multimodal representa un cambio de paradigma en el análisis de contenido impulsado por inteligencia artificial. Estos modelos son capaces de procesar diferentes formas de contenido —texto, imágenes, audio y video— lo que los acerca a la percepción humana y mejora la interacción con los usuarios. ByteDance ha desarrollado una arquitectura de LLMs que no solo maximiza el rendimiento en una variedad de aplicaciones, sino que también integra múltiples flujos de entrada para una comprensión más profunda del contenido.

La estrategia que ha llevado a cabo ByteDance incluye la implementación de técnicas avanzadas como la paralelización de tensores y el uso de grupos de procesamiento estático, lo que ha mejorado tanto la latencia como el rendimiento de sus modelos de forma significativa. Estas optimizaciones son clave para poder manejar el creciente volumen de contenido y garantizar una respuesta rápida a las demandas del mercado.

De cara al futuro, ByteDance planea desarrollar un tokenizador multimodal unificado, que permitirá procesar todos los tipos de contenido dentro de un espacio semántico común. Esta innovación promete mejorar la eficiencia y la coherencia en la comprensión de contenidos, además de sentar las bases para un sistema más inclusivo y seguro en el ecosistema digital actual.

La colaboración con AWS no solo ha sido vital para superar los desafíos del análisis de videos, sino que también ha abierto nuevas posibilidades en el ámbito de la inteligencia artificial. A medida que ByteDance continúa expandiendo sus capacidades y probando nuevas tecnologías, se mantiene en la vanguardia de la innovación en un mundo digital en constante evolución.

vía: AWS machine learning blog